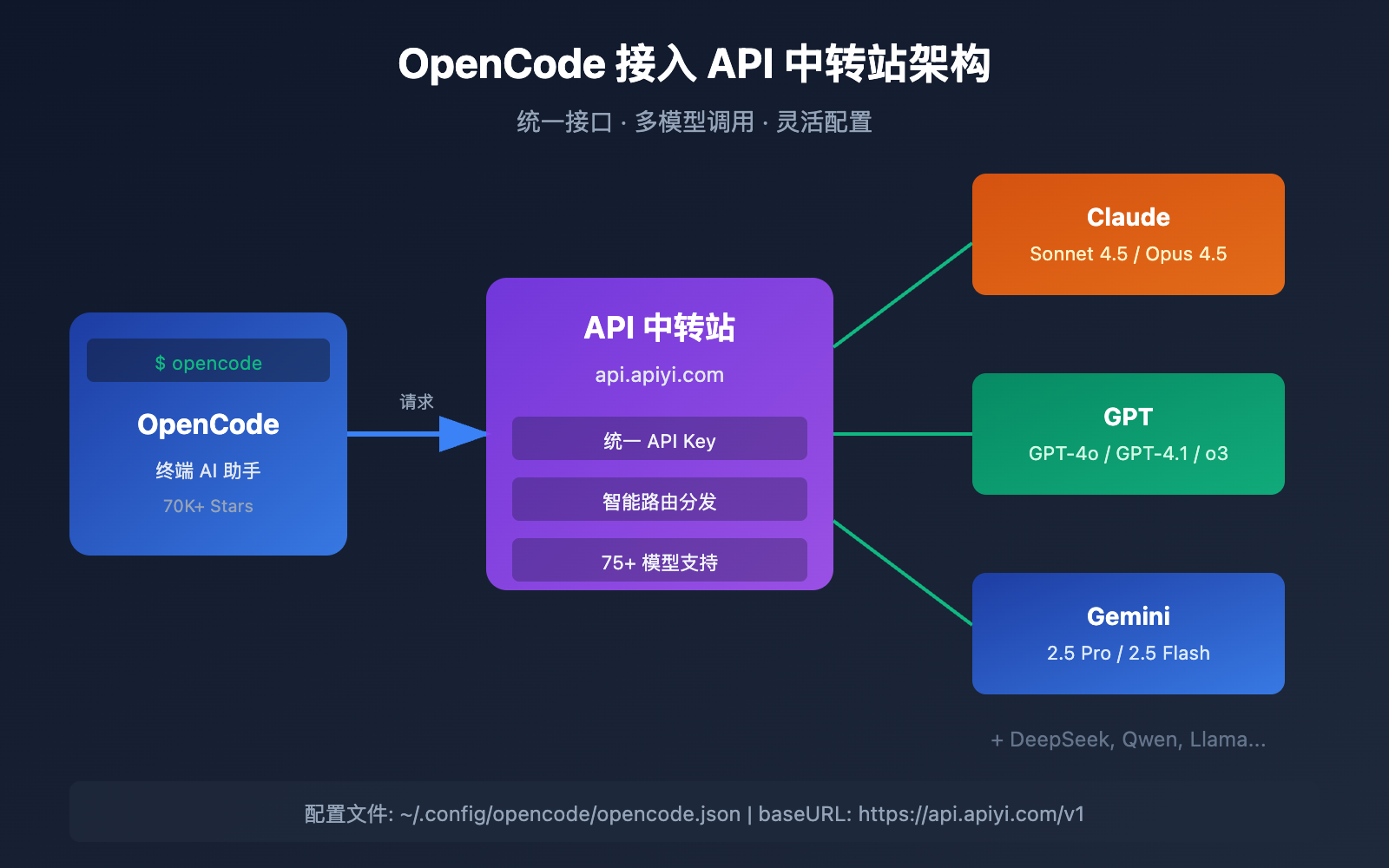

OpenCode 作为开源 AI 编程助手无法直接使用官方 API 是很多开发者面临的问题。本文将介绍 OpenCode 接入 API 中转站 的完整配置方法,帮助你快速实现 300+ 模型的统一调用。

核心价值: 读完本文,你将学会在 OpenCode 中配置自定义 API 端点,无需官方 API 即可使用 Claude、GPT、Gemini 等主流模型。

OpenCode 简介与 API 中转站核心价值

什么是 OpenCode

OpenCode 是一款完全开源的终端 AI 编程助手,由 Anomaly 团队开发维护。与 Claude Code 类似,OpenCode 提供强大的代码生成、文件编辑、项目分析等功能,但最大的优势在于 Provider 无关性 —— 不绑定任何单一 AI 提供商。

| 特性 | OpenCode | Claude Code |

|---|---|---|

| 开源程度 | 完全开源 | 闭源 |

| 模型支持 | 75+ 模型可选 | 仅 Claude |

| Provider 锁定 | 无锁定 | 绑定 Anthropic |

| 本地模型 | 支持 Ollama 等 | 不支持 |

| GitHub Stars | 70,000+ | N/A |

| 活跃贡献者 | 500+ | N/A |

为什么需要 API 中转站

直接使用官方 API 存在以下挑战:

- 访问受限: 部分地区无法直接访问 OpenAI、Anthropic 等官方 API

- 支付困难: 官方 API 需要国际信用卡绑定

- 成本较高: 官方定价对个人开发者不够友好

- 切换成本: 不同模型需要不同的 API Key 和端点配置

API 中转站通过统一接口解决上述问题:

🎯 技术建议: 通过 API易 apiyi.com 平台接入,可以使用统一的 API Key 调用 Claude、GPT、Gemini 等 75+ 模型,无需分别申请各厂商账号。

OpenCode API 中转站配置核心要点

在开始配置之前,了解以下核心要点将帮助你避免常见错误:

| 要点 | 说明 | 价值 |

|---|---|---|

| 配置文件位置 | 全局 ~/.config/opencode/opencode.json,项目级 ./opencode.json |

灵活管理不同项目配置 |

| baseURL 格式 | 必须以 /v1 结尾,如 https://api.apiyi.com/v1 |

确保 API 兼容性 |

| 认证存储 | API Key 存储在 ~/.local/share/opencode/auth.json |

安全隔离敏感信息 |

| 配置合并 | 多配置文件按优先级合并,项目级覆盖全局 | 支持团队统一配置 |

| 模型声明 | 自定义 Provider 需显式声明可用模型 | 确保模型列表正确 |

OpenCode 配置文件优先级

OpenCode 支持多层配置,按以下优先级从低到高合并:

远程配置 (.well-known/opencode)

↓

全局配置 (~/.config/opencode/opencode.json)

↓

环境变量 (OPENCODE_CONFIG)

↓

项目配置 (./opencode.json)

↓

内联配置 (OPENCODE_CONFIG_CONTENT)

OpenCode 配置格式说明

OpenCode 支持 JSON 和 JSONC (带注释的 JSON) 两种格式,推荐使用 JSONC 以便添加配置说明:

{

// OpenCode 配置文件 - 支持注释

"$schema": "https://opencode.ai/config.json",

"model": "anthropic/claude-sonnet-4-5",

"provider": {

// Provider 配置区域

}

}

OpenCode 接入 API 中转站快速上手

方式一: 内置 Provider 修改 baseURL (推荐)

如果你想使用的模型属于 OpenCode 内置支持的 Provider (如 Anthropic、OpenAI),只需修改 baseURL 即可:

{

"$schema": "https://opencode.ai/config.json",

"model": "anthropic/claude-sonnet-4-5",

"provider": {

"anthropic": {

"options": {

"baseURL": "https://api.apiyi.com/v1"

}

}

}

}

然后通过 /connect 命令添加 API Key:

# 启动 OpenCode

opencode

# 在 TUI 中输入

/connect

# 选择 Anthropic

# 输入从 API易 获取的 API Key

🚀 快速开始: 推荐使用 API易 apiyi.com 平台获取统一 API Key,一个 Key 即可调用 Claude、GPT、Gemini 等主流模型。

方式二: 自定义 OpenAI 兼容 Provider

对于 API 中转站,更推荐创建自定义 Provider,可以更灵活地管理模型列表:

{

"$schema": "https://opencode.ai/config.json",

"model": "apiyi/claude-sonnet-4-5",

"provider": {

"apiyi": {

"npm": "@ai-sdk/openai-compatible",

"name": "API易",

"options": {

"baseURL": "https://api.apiyi.com/v1"

},

"models": {

"claude-sonnet-4-5": {

"name": "Claude Sonnet 4.5"

},

"claude-opus-4-5": {

"name": "Claude Opus 4.5"

},

"gpt-4o": {

"name": "GPT-4o"

},

"gpt-4o-mini": {

"name": "GPT-4o Mini"

},

"gemini-2.5-pro": {

"name": "Gemini 2.5 Pro"

},

"deepseek-r1": {

"name": "DeepSeek R1"

}

}

}

}

}

查看完整配置示例 (含更多模型)

{

"$schema": "https://opencode.ai/config.json",

"model": "apiyi/claude-sonnet-4-5",

"small_model": "apiyi/gpt-4o-mini",

"theme": "opencode",

"autoupdate": true,

"provider": {

"apiyi": {

"npm": "@ai-sdk/openai-compatible",

"name": "API易 - 统一 AI 接口",

"options": {

"baseURL": "https://api.apiyi.com/v1",

"timeout": 300000

},

"models": {

"claude-sonnet-4-5": {

"name": "Claude Sonnet 4.5",

"limit": {

"context": 200000,

"output": 64000

}

},

"claude-opus-4-5": {

"name": "Claude Opus 4.5",

"limit": {

"context": 200000,

"output": 32000

}

},

"claude-haiku-4-5": {

"name": "Claude Haiku 4.5",

"limit": {

"context": 200000,

"output": 8192

}

},

"gpt-4o": {

"name": "GPT-4o",

"limit": {

"context": 128000,

"output": 16384

}

},

"gpt-4o-mini": {

"name": "GPT-4o Mini",

"limit": {

"context": 128000,

"output": 16384

}

},

"gpt-4.1": {

"name": "GPT-4.1",

"limit": {

"context": 1000000,

"output": 32768

}

},

"o1": {

"name": "OpenAI o1",

"limit": {

"context": 200000,

"output": 100000

}

},

"o3": {

"name": "OpenAI o3",

"limit": {

"context": 200000,

"output": 100000

}

},

"gemini-2.5-pro": {

"name": "Gemini 2.5 Pro",

"limit": {

"context": 1000000,

"output": 65536

}

},

"gemini-2.5-flash": {

"name": "Gemini 2.5 Flash",

"limit": {

"context": 1000000,

"output": 65536

}

},

"deepseek-r1": {

"name": "DeepSeek R1",

"limit": {

"context": 128000,

"output": 8192

}

},

"deepseek-v3": {

"name": "DeepSeek V3",

"limit": {

"context": 128000,

"output": 8192

}

},

"qwen3-235b": {

"name": "Qwen3 235B",

"limit": {

"context": 128000,

"output": 8192

}

}

}

}

},

"disabled_providers": [

"openai",

"anthropic",

"google"

]

}

方式三: 环境变量配置

对于 CI/CD 或临时测试场景,可以使用环境变量:

# 设置 API Key 环境变量

export ANTHROPIC_API_KEY="sk-your-apiyi-key"

# 或使用 OpenCode 专用环境变量

export OPENCODE_CONFIG_CONTENT='{

"model": "anthropic/claude-sonnet-4-5",

"provider": {

"anthropic": {

"options": {

"baseURL": "https://api.apiyi.com/v1"

}

}

}

}'

# 启动 OpenCode

opencode

OpenCode API 中转站支持的模型对比

通过 API 中转站,OpenCode 可以调用以下主流模型:

代码生成模型推荐

| 模型 | 提供商 | 上下文 | 代码能力 | 适用场景 | API易 支持 |

|---|---|---|---|---|---|

| Claude Sonnet 4.5 | Anthropic | 200K | ⭐⭐⭐⭐⭐ | 复杂代码生成 | ✅ |

| Claude Opus 4.5 | Anthropic | 200K | ⭐⭐⭐⭐⭐ | 高难度任务 | ✅ |

| GPT-4.1 | OpenAI | 1M | ⭐⭐⭐⭐⭐ | 超长上下文 | ✅ |

| o3 | OpenAI | 200K | ⭐⭐⭐⭐⭐ | 推理任务 | ✅ |

| Gemini 2.5 Pro | 1M | ⭐⭐⭐⭐ | 多模态代码 | ✅ | |

| DeepSeek R1 | DeepSeek | 128K | ⭐⭐⭐⭐ | 性价比首选 | ✅ |

| Qwen3 235B | 阿里 | 128K | ⭐⭐⭐⭐ | 中文代码 | ✅ |

轻量级模型推荐 (适合 small_model)

| 模型 | 响应速度 | 成本 | 推荐用途 |

|---|---|---|---|

| GPT-4o-mini | 极快 | 极低 | 标题生成、简单任务 |

| Claude Haiku 4.5 | 快 | 低 | 代码补全、快速回答 |

| Gemini 2.5 Flash | 快 | 低 | 多模态轻量任务 |

💡 选择建议: 选择哪个模型主要取决于您的具体任务类型。我们建议通过 API易 apiyi.com 平台进行实际测试,平台支持按量计费,便于对比不同模型的效果和成本。

OpenCode API 中转站高级配置

配置多个 Provider

OpenCode 支持同时配置多个 Provider,通过 Tab 键或 /model 命令切换:

{

"$schema": "https://opencode.ai/config.json",

"model": "apiyi/claude-sonnet-4-5",

"provider": {

"apiyi": {

"npm": "@ai-sdk/openai-compatible",

"name": "API易",

"options": {

"baseURL": "https://api.apiyi.com/v1"

},

"models": {

"claude-sonnet-4-5": { "name": "Claude Sonnet 4.5" },

"gpt-4o": { "name": "GPT-4o" }

}

},

"ollama": {

"npm": "@ai-sdk/openai-compatible",

"name": "Ollama Local",

"options": {

"baseURL": "http://localhost:11434/v1"

},

"models": {

"qwen3:32b": { "name": "Qwen3 32B Local" }

}

}

}

}

配置请求超时

对于大型代码库分析,建议增加超时时间:

{

"provider": {

"apiyi": {

"options": {

"baseURL": "https://api.apiyi.com/v1",

"timeout": 600000

}

}

}

}

配置上下文限制

明确指定模型的上下文和输出限制,避免请求失败:

{

"models": {

"claude-sonnet-4-5": {

"name": "Claude Sonnet 4.5",

"limit": {

"context": 200000,

"output": 64000

}

}

}

}

禁用官方 Provider

如果只想使用中转站,可以禁用内置 Provider:

{

"disabled_providers": [

"openai",

"anthropic",

"google",

"opencode-zen"

]

}

OpenCode API 中转站配置验证

配置完成后,按以下步骤验证:

步骤 1: 检查配置文件

# 查看全局配置

cat ~/.config/opencode/opencode.json

# 查看认证信息 (API Key 存储位置)

cat ~/.local/share/opencode/auth.json

步骤 2: 启动 OpenCode 验证

# 启动 OpenCode

opencode

# 查看当前模型

/model

# 查看已连接的 Provider

/provider

步骤 3: 测试 API 调用

在 OpenCode 中输入简单提示验证连接:

请写一个 Python 的 Hello World 程序

如果返回正常响应,说明配置成功。

常见验证问题

| 问题 | 检查点 | 解决方案 |

|---|---|---|

| 模型列表为空 | models 配置 |

确保显式声明模型 |

| 连接超时 | 网络/baseURL | 检查网络,确认 URL 正确 |

| 401 认证失败 | API Key | 重新通过 /connect 添加 |

| 模型不存在 | 模型 ID | 确认中转站支持该模型 |

OpenCode API 中转站常见问题

Q1: OpenCode 配置 API 中转站后提示 “model not found” 怎么办?

这通常是因为自定义 Provider 没有正确声明模型列表。确保在 models 字段中明确列出可用模型:

{

"provider": {

"apiyi": {

"models": {

"claude-sonnet-4-5": { "name": "Claude Sonnet 4.5" }

}

}

}

}

同时确认 model 字段使用正确的格式: provider-id/model-id,如 apiyi/claude-sonnet-4-5。

通过 API易 apiyi.com 平台可以查看完整的模型列表和正确的 model ID。

Q2: 如何在 OpenCode 中切换不同模型?

有三种方式切换模型:

- 命令切换: 输入

/model查看并选择模型 - 配置切换: 修改

opencode.json中的model字段 - 快捷键: 按

Tab键在 build 和 plan Agent 间切换

建议通过 API易 apiyi.com 接入,一个配置即可切换 Claude、GPT、Gemini 等多种模型。

Q3: OpenCode 的 API Key 存储在哪里?安全吗?

API Key 存储在 ~/.local/share/opencode/auth.json 文件中。这是用户数据目录,权限默认为当前用户可读写。

安全建议:

- 避免将

auth.json提交到版本控制 - 定期轮换 API Key

- 使用环境变量在 CI/CD 中传递 Key

Q4: 配置文件不生效怎么排查?

按以下顺序排查:

- 格式检查: JSON 语法是否正确 (推荐用 VS Code 打开检查)

- 位置检查: 全局配置在

~/.config/opencode/opencode.json - 优先级检查: 项目级配置会覆盖全局配置

- 重启验证: 修改配置后重启 OpenCode

Q5: OpenCode 和 Claude Code 哪个更适合接入中转站?

OpenCode 更适合中转站场景:

| 对比项 | OpenCode | Claude Code |

|---|---|---|

| 自定义端点 | 原生支持 | 需要特殊配置 |

| 多模型切换 | 内置支持 | 仅 Claude |

| 配置灵活性 | 高 | 低 |

| 开源可审计 | 是 | 否 |

如果你需要使用多种模型或中转站服务,OpenCode 是更好的选择。

OpenCode API 中转站配置总结

通过本文,你已经学会了在 OpenCode 中配置 API 中转站的 3 种方法:

- 内置 Provider 修改 baseURL – 最简单,适合单一模型

- 自定义 OpenAI 兼容 Provider – 最灵活,适合多模型管理

- 环境变量配置 – 最适合 CI/CD 场景

关键配置要点回顾

| 配置项 | 推荐值 |

|---|---|

| 配置文件 | ~/.config/opencode/opencode.json |

| baseURL | https://api.apiyi.com/v1 |

| npm 包 | @ai-sdk/openai-compatible |

| 超时设置 | 300000-600000 ms |

OpenCode 作为开源的终端 AI 编程助手,配合 API 中转站可以发挥最大价值。推荐通过 API易 apiyi.com 快速验证配置效果,获取稳定的 API 服务。

如有问题,欢迎通过 API易 apiyi.com 技术支持获取帮助。

作者: APIYI Team

更新时间: 2026 年 1 月

技术支持: 如需 OpenCode 配置帮助,访问 API易 apiyi.com 获取技术支持