站长注:深度解析 OpenAI 新推出的 Responses API 与经典 Chat Completions API 的区别、优势和应用场景

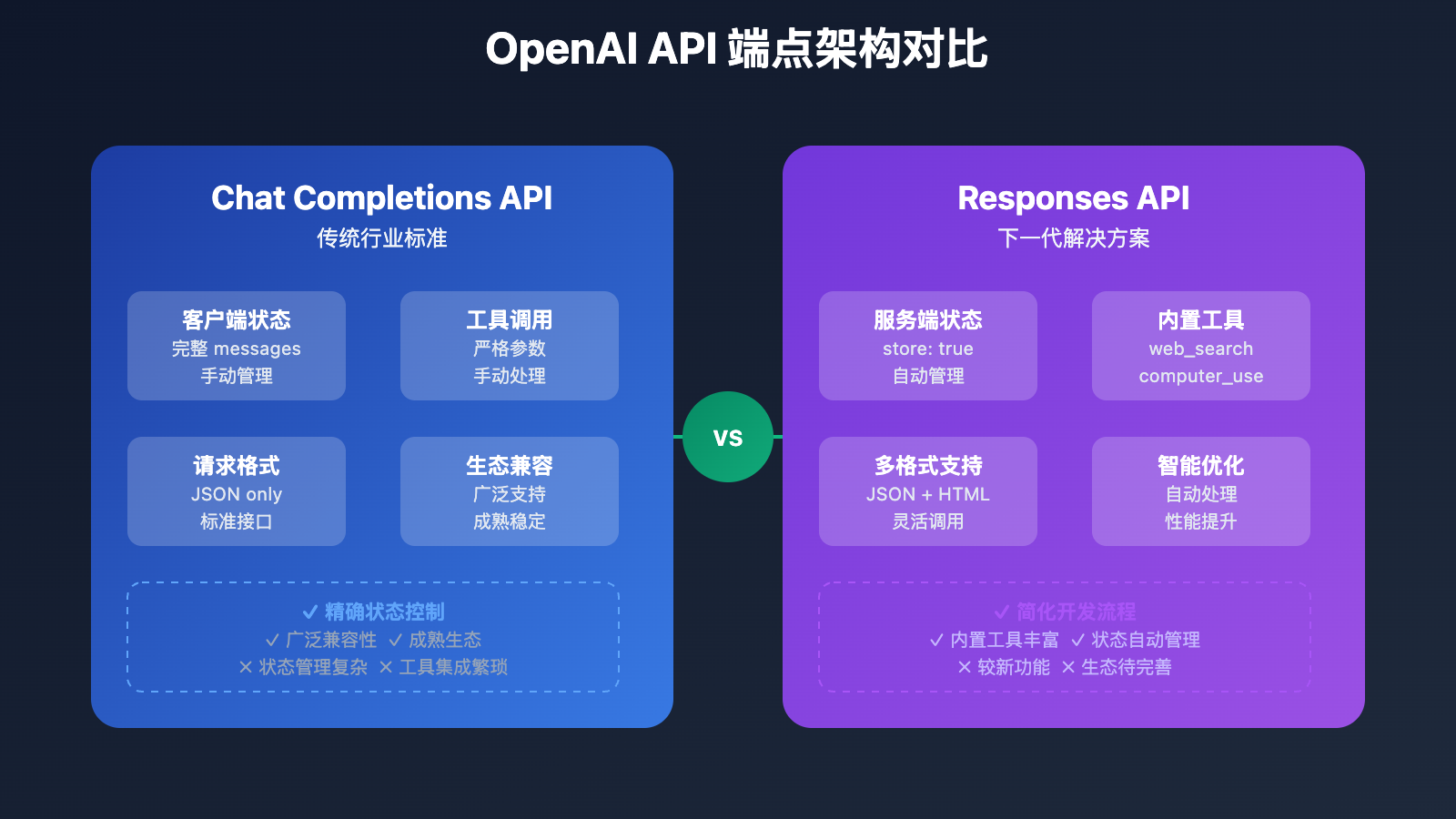

在AI应用开发中,开发者经常会遇到一个关键选择:使用哪个API端点来构建对话系统?OpenAI 最近推出了全新的 Responses API,与我们熟悉的 Chat Completions API 形成了两套并行的解决方案。许多开发者在实际使用中发现,这两个端点在功能调用、状态管理和响应格式上存在显著差异。

本文将通过实际案例和技术对比,深入分析 Responses API 和 Chat Completions API 的核心区别,包括各自的优势、适用场景和迁移策略。无论你是刚接触 OpenAI API 的新手,还是考虑升级现有系统的开发者,都能从中获得实用的技术指导。

文章涵盖两个端点的技术架构对比、功能特性分析、性能差异测试,以及生产环境部署建议,帮助你在项目中做出最佳的技术选择。而 API易 系统均支持这两个模式。

OpenAI API 端点 背景介绍

OpenAI 在 2025 年 3 月推出了全新的 Responses API,这标志着 AI 应用开发进入了新的阶段。传统的 Chat Completions API 已经成为行业标准,被广泛采用和模仿,但在处理复杂对话、工具调用和状态管理方面存在一些挑战。

Responses API 的推出旨在简化涉及工具使用、代码执行和状态管理的工作流程。与此同时,OpenAI 明确表示将继续无限期支持 Chat Completions API,确保现有应用的稳定性。值得注意的是,原本的 Assistants API 将在 2026 年上半年被淘汰,其功能被更加高效的 Responses API 所取代。

OpenAI API 端点 核心功能

以下是 两个 API 端点 的核心功能特性对比:

| 功能模块 | Chat Completions API | Responses API | 推荐指数 |

|---|---|---|---|

| 会话状态管理 | 客户端维护完整对话历史 | 服务端自动管理状态 | ⭐⭐⭐⭐⭐ |

| 结构化输出 | response_format,稳定性一般 | text_format,解析更稳定 | ⭐⭐⭐⭐⭐ |

| 工具调用处理 | 需要手动管理工具输出 | 内置工具执行和状态跟踪 | ⭐⭐⭐⭐⭐ |

| 请求格式 | 仅支持 JSON | 支持 JSON 和 HTML 表单编码 | ⭐⭐⭐⭐ |

| 内置工具 | 需要自定义实现 | 提供 web_search、file_search、computer_use | ⭐⭐⭐⭐⭐ |

🔥 重点功能详解

Chat Completions API 特点

Chat Completions API 是目前的行业标准,采用无状态设计:

{

"model": "gpt-4o-mini",

"messages": [

{

"role": "user",

"content": "knock knock."

},

{

"role": "assistant",

"content": "Who's there?"

},

{

"role": "user",

"content": "Orange."

}

]

}

核心特征:

- 每次请求需要发送完整的对话历史

- 客户端负责维护会话状态

- 工具调用需要手动处理返回结果

Responses API 创新特性

Responses API 引入了服务端状态管理:

{

"model": "gpt-4o",

"input": "What is the capital of France?",

"store": true,

"tools": [

{"type": "web_search_preview"}

]

}

创新亮点:

store: true启用服务端状态存储previous_response_id继续之前的对话- 内置工具无需额外配置

OpenAI API 端点 应用场景

两个 API 端点 在以下场景中各有优势:

| 应用场景 | 适用对象 | Chat Completions 优势 | Responses API 优势 |

|---|---|---|---|

| 🎯 简单问答系统 | 初学者、小型项目 | 实现简单,成本可控 | 状态管理更便捷 |

| 🚀 复杂对话机器人 | 企业级应用 | 状态控制精确 | 大幅简化开发复杂度 |

| 💡 数据提取应用 | 结构化数据处理 | 基础解析功能 | 结构化输出更稳定 |

| 🔧 工具集成应用 | 自动化系统 | 灵活的自定义工具 | 内置工具开箱即用 |

| 🤖 多轮协作任务 | AI Agent 系统 | 精确的状态管理 | 自动化的上下文处理 |

OpenAI API 端点 技术实现

💻 基础调用对比示例

Chat Completions API 调用

# 🚀 传统的 Chat Completions 调用

curl https://vip.apiyi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $YOUR_API_KEY" \

-d '{

"model": "gpt-4o-mini",

"messages": [

{"role": "system", "content": "你是一个helpful的AI助手"},

{"role": "user", "content": "解释一下量子计算的基本原理"}

]

}'

Responses API 调用示例

# 🚀 新式的 Responses API 调用

curl https://vip.apiyi.com/v1/responses \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $YOUR_API_KEY" \

-d '{

"model": "gpt-4o",

"input": "解释一下量子计算的基本原理",

"instructions": "你是一个helpful的AI助手",

"store": true

}'

HTML 表单格式调用(Responses API 独有):

curl https://vip.apiyi.com/v1/responses \

-u :$YOUR_API_KEY \

-d model="gpt-4o" \

-d input="What is the capital of France?"

🎯 功能调用差异分析

结构化输出处理差异

基于实际客户反馈,Responses API 在结构化输出方面表现更加稳定可靠。以下是一个典型的对比案例:

from openai import OpenAI

from pydantic import BaseModel

client = OpenAI(base_url="https://vip.apiyi.com/v1")

class CalendarEvent(BaseModel):

name: str

date: str

participants: list[str]

# Chat Completions API - 可能出现解析错误

try:

completion = client.beta.chat.completions.parse(

model="gpt-4o-mini",

messages=[

{"role": "system", "content": "Extract the event information."},

{"role": "user", "content": "Alice and Bob are going to a science fair on Friday."}

],

response_format=CalendarEvent,

)

event = completion.choices[0].message.parsed

print("Chat Completions结果:", event)

except Exception as e:

print(f"Chat Completions解析失败: {e}")

# Responses API - 结构化输出更稳定

response = client.responses.parse(

model="gpt-4o",

input=[

{"role": "system", "content": "Extract the event information."},

{"role": "user", "content": "Alice and Bob are going to a science fair on Friday."}

],

text_format=CalendarEvent,

)

event = response.output_parsed

print("Responses API结果:", event)

# 输出: CalendarEvent(name='science fair', date='Friday', participants=['Alice', 'Bob'])

关键差异分析:

- Chat Completions: 使用

response_format参数,在复杂结构时可能出现解析错误 - Responses API: 使用

text_format参数,内置了更强的结构化输出处理机制 - 稳定性: Responses API 在处理嵌套对象、数组等复杂结构时表现更佳

工具调用的关键差异

除了结构化输出,两个端点在工具调用方面也存在显著差异:

# Chat Completions API - 工具调用示例

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

# Chat Completions 需要严格的参数定义

response = client.chat.completions.create(

model="gpt-4o-mini",

tools=[{

"type": "function",

"function": {

"name": "get_calendar_events",

"parameters": {

"type": "object",

"properties": {

"calendarId": {"type": "string"},

"timeMin": {"type": "string"},

"timeMax": {"type": "string"}

},

"required": ["calendarId", "timeMin", "timeMax"]

}

}

}],

messages=[

{"role": "user", "content": "查看今天的会议"}

]

)

# 返回完整的工具调用参数

# {"calendarId":"primary","timeMin":"2025-01-15T00:00:00+08:00","timeMax":"2025-01-16T00:00:00+08:00"}

# Responses API - 相同的工具调用

response = client.responses.create(

model="gpt-4o",

tools=[{

"type": "function",

"name": "get_calendar_events",

"parameters": {

"type": "object",

"properties": {

"calendarId": {"type": "string"},

"timeMin": {"type": "string"},

"timeMax": {"type": "string"}

},

"required": ["calendarId"] # 注意:更灵活的必填参数

}

}],

input="查看今天的会议"

)

# 可能只返回部分参数(需要 strict mode 确保完整性)

# {"calendarId":"primary","timeMin":"2025-01-14T21:00:00Z"}

状态管理机制对比

| 特性 | Chat Completions | Responses API | 优势评估 |

|---|---|---|---|

| 状态存储 | 客户端维护 | 服务端自动管理 | Responses API 减少开发复杂度 |

| 上下文传递 | 完整 messages 数组 | previous_response_id | Responses API 减少网络传输 |

| 工具结果处理 | 手动添加到 messages | 自动集成到会话 | Responses API 简化工作流 |

| 内存使用 | 客户端负责优化 | 服务端优化管理 | Responses API 更高效 |

🔧 高级功能特性

Responses API 独有的内置工具

# 网络搜索工具

response = client.responses.create(

model="gpt-4o",

input="2025年AI发展趋势",

tools=[{"type": "web_search_preview"}]

)

# 文件搜索工具

response = client.responses.create(

model="gpt-4o",

input="分析这份文档的要点",

tools=[{

"type": "file_search",

"vector_store_ids": ["vs_123456"]

}]

)

# 计算机使用工具(预览版)

response = client.responses.create(

model="gpt-4o",

input="帮我打开浏览器并搜索信息",

tools=[{

"type": "computer_use_preview",

"display_width": 1024,

"display_height": 768,

"environment": "browser"

}]

)

性能和成本对比

| 工具类型 | 使用成本 | 适用场景 | 性能特点 |

|---|---|---|---|

| web_search_preview | $25-50/千次查询 | 实时信息获取 | 响应快,结果准确 |

| file_search | $2.50/千次查询 + $0.10/GB/天 | 文档分析,RAG应用 | 第一个GB免费 |

| computer_use_preview | 按模型调用计费 | 自动化操作 | 需要额外安全考虑 |

✅ OpenAI API 端点 最佳实践

| 实践要点 | Chat Completions 建议 | Responses API 建议 | 注意事项 |

|---|---|---|---|

| 🎯 状态管理 | 实现客户端缓存和清理机制 | 合理使用 store 参数 | 避免状态泄露 |

| ⚡ 错误处理 | 处理完整的 messages 验证 | 关注 response_id 的有效性 | 两者都需要重试机制 |

| 💡 性能优化 | 优化 messages 数组长度 | 利用服务端状态管理 | 监控请求响应时间 |

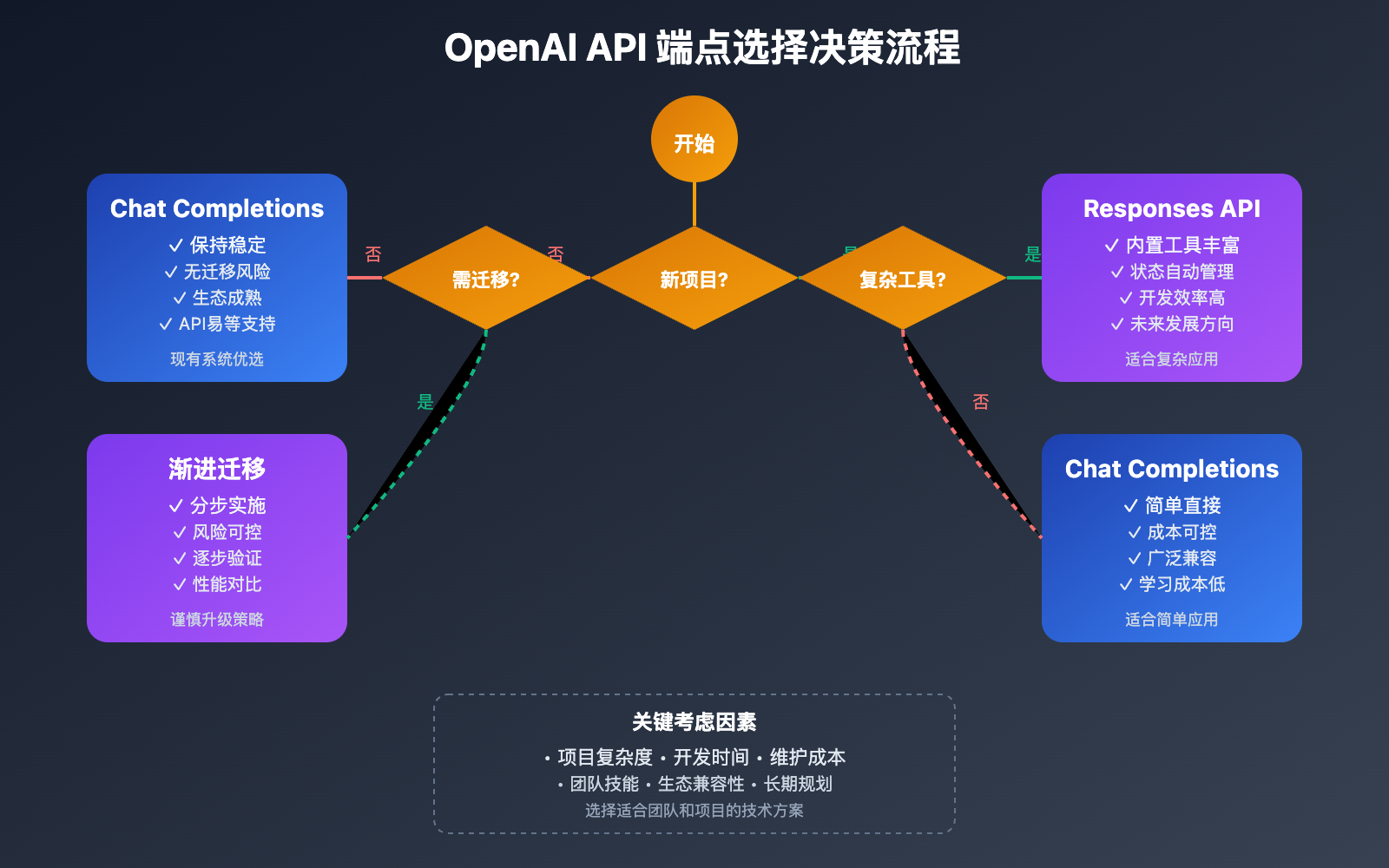

📋 迁移策略建议

| 迁移场景 | 推荐策略 | 预期收益 |

|---|---|---|

| 简单对话应用 | 保持 Chat Completions | 稳定性优先,无需迁移 |

| 复杂工具集成 | 逐步迁移到 Responses API | 开发效率提升50%+ |

| 新项目开发 | 优先考虑 Responses API | 更好的扩展性和维护性 |

🔍 调试和监控差异

两个端点的调试方法有所不同:

# Chat Completions 调试

def debug_chat_completions(response):

print("消息历史长度:", len(response.choices[0].message))

print("工具调用:", response.choices[0].message.tool_calls)

print("完成原因:", response.choices[0].finish_reason)

# Responses API 调试

def debug_responses(response):

print("响应ID:", response.id)

print("输出内容:", response.output)

print("工具执行:", response.tool_calls)

print("状态信息:", response.metadata)

❓ OpenAI API 端点 常见问题

Q1: 什么时候应该选择 Responses API 而不是 Chat Completions?

选择 Responses API 的关键场景:

推荐使用 Responses API:

- 需要复杂的多轮对话管理

- 大量使用工具调用和外部集成

- 希望减少客户端状态管理复杂度

- 需要稳定的结构化数据输出(如数据提取、内容解析)

- 需要使用内置的 web_search、file_search 等工具

继续使用 Chat Completions:

- 现有系统稳定运行,无迁移需求

- 需要精确控制会话状态

- 对成本控制有严格要求

- 使用第三方平台(如API易等聚合服务)可能暂时只支持标准接口

Q2: 为什么 Responses API 在结构化输出方面更稳定?

结构化输出稳定性差异的主要原因:

技术架构差异:

- Chat Completions: 使用

beta.chat.completions.parse()方法,依赖客户端解析 - Responses API: 使用

responses.parse()方法,服务端原生支持结构化输出

实际表现对比:

# Chat Completions - 复杂嵌套结构可能失败

class ComplexEvent(BaseModel):

event: dict[str, Any]

attendees: list[dict[str, str]]

metadata: Optional[dict] = None

# Responses API - 处理复杂结构更稳定

response = client.responses.parse(

model="gpt-4o",

input="Extract detailed event information...",

text_format=ComplexEvent

)

优势总结:

- 服务端原生解析,减少网络传输中的数据损失

- 更好的类型推断和验证机制

- 对嵌套对象、可选字段的处理更稳定

- 错误处理更友好,提供详细的解析失败信息

Q3: 两个端点的工具调用为什么会有差异?

工具调用差异的主要原因:

# 关键差异在于参数验证严格程度

# Chat Completions: 更严格的参数要求

{

"required": ["calendarId", "timeMin", "timeMax"] # 必须提供所有参数

}

# Responses API: 更灵活的参数处理

{

"required": ["calendarId"] # 只要求核心参数

}

解决方案:

- 在 Responses API 中启用

strict: true模式 - 在工具定义中明确所有必需参数

- 添加参数验证逻辑确保一致性

Q4: 如何处理 API 端点之间的迁移?

系统性迁移建议:

# 1. 创建适配器模式

class APIAdapter:

def __init__(self, use_responses_api=False):

self.use_responses = use_responses_api

def create_completion(self, **kwargs):

if self.use_responses:

return self._call_responses_api(**kwargs)

else:

return self._call_chat_completions(**kwargs)

# 2. 逐步切换

# 第一步:并行运行,对比结果

# 第二步:灰度发布,部分流量使用新API

# 第三步:全量切换并监控性能

迁移检查清单:

- ✅ 工具调用参数一致性验证

- ✅ 状态管理逻辑调整

- ✅ 错误处理机制更新

- ✅ 性能监控指标对比

- ✅ 成本变化评估

📚 延伸阅读

🛠️ 开源资源

完整的API端点对比示例已开源到GitHub,包含迁移工具和性能测试:

# 快速体验两个端点的差异

git clone https://github.com/apiyi-api/openai-api-comparison

cd openai-api-comparison

# 配置环境变量

export OPENAI_API_KEY=your_key

export API_BASE_URL=https://vip.apiyi.com/v1

# 运行对比测试

python compare_apis.py

项目包含内容:

- Chat Completions vs Responses API 功能对比

- 工具调用差异测试和解决方案

- 性能基准测试脚本

- 迁移助手工具

- 最佳实践示例代码

🔗 相关文档

| 资源类型 | 推荐内容 | 获取方式 |

|---|---|---|

| 官方文档 | OpenAI Responses vs Chat Completions 指南 | https://platform.openai.com/docs/guides/responses-vs-chat-completions |

| 社区资源 | API易使用文档和迁移指南 | https://help.apiyi.com |

| 技术博客 | Simon Willison 的深度分析 | https://simonwillison.net/2025/Mar/11/responses-vs-chat-completions/ |

| 开发者论坛 | OpenAI 开发者社区讨论 | https://community.openai.com |

🎯 总结

通过深入分析 OpenAI 的两个 API 端点,我们了解了它们在设计理念、功能特性和应用场景方面的关键差异。

重点回顾:Responses API 在状态管理和工具集成方面具有明显优势,而 Chat Completions API 在稳定性和生态兼容性方面更有保障

在实际应用中,建议:

- 新项目优先考虑 Responses API 的先进特性

- 现有系统可稳步规划迁移策略

- 根据业务复杂度选择合适的端点

- 重视两个端点的功能调用差异,做好测试验证

对于生产环境部署,推荐使用支持多端点的 API 聚合平台(如 API易等),既能保证服务稳定性,又能灵活切换不同的 OpenAI 端点,满足不同阶段的技术需求。

📝 作者简介:资深AI应用架构师,专注OpenAI API集成与优化实践。定期分享API开发经验和最新技术动态,搜索"API易"可找到更多技术资料和实战案例。

🔔 技术交流:欢迎在评论区讨论API选择和迁移问题,持续分享AI开发经验和行业趋势。