站长注:本文深入介绍 OpenAI 于 2025 年 1 月 31 日发布的 o3-mini 模型,这是一款高性价比的小型推理模型,在保持高智能水平的同时,提供了更快的响应速度和更多的开发者功能。

已上线 API 易,调用模型名称:o3-mini 和 o3-mini-2025-01-31

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持 o3-mini 等全系列模型,让 AI 开发更简单

注册即送 1.1 美金额度,立即免费注册 www.apiyi.com

模型概览

o3-mini 是 OpenAI 最新推出的小型推理模型,专为科学、数学和编程任务优化设计。以下是其核心特点:

1. 基本参数

| 特性 | 参数 |

|---|---|

| 上下文窗口 | 200,000 tokens |

| 最大输出 | 100,000 tokens |

| 知识截止 | 2023年10月 |

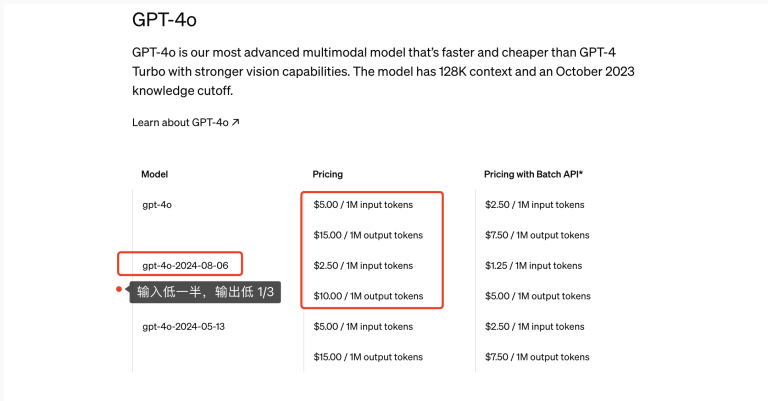

| 输入价格 | $2/百万tokens(API易) |

| 输出价格 | $8/百万tokens(API易) |

2. 核心优势

- 高性价比:与 o1-mini 相同的成本和延迟目标下,提供更高的智能水平

- 开发者友好:支持多种高级功能

- 专业领域优化:在科学、数学和编程任务中表现出色

技术特点

1. 开发者功能支持

- 结构化输出

- JSON 格式输出

- 自定义数据结构

- 标准化响应格式

- 函数调用

- 支持自定义函数

- 参数验证

- 类型检查

- 批量处理 API

- 并行请求处理

- 批量任务优化

- 提高处理效率

2. 推理能力

- 多级推理强度

- 低强度:快速响应,优化速度,保持基本推理能力

- 中强度:平衡模式,性能与 o1 相当(默认模式)

- 高强度:深度思考,在 STEM 领域超过 o1(每周限制 50 次)

重要提示:通过

reasoning_effort参数可以灵活控制模型的推理强度,根据任务需求选择合适的级别。

# 推理强度控制示例

response = openai.ChatCompletion.create(

model="o3-mini",

messages=[

{"role": "user", "content": "分析这个复杂的数学问题"}

],

reasoning_effort="high" # 可选值: "low", "medium"(默认是这个), "high"

)

注意了:默认情况下如果不指定 reasoning_effort 参数,是使用 medium 级别

- 性能表现

- AIME 2024 测试优于 o1

- GPQA Diamond 测试表现出色

- 数学和编程能力显著

3. 特性限制

- 不支持视觉功能

- 知识截止到 2023 年 10 月

- 需要合理控制输入长度

应用场景

1. 科学计算

- 数学问题求解

- 复杂方程推导

- 数学证明辅助

- 统计分析计算

- 科学研究辅助

- 数据分析

- 实验设计

- 结果验证

2. 代码开发

- 编程助手

- 代码生成

- 错误诊断

- 性能优化

- 代码审查

- 代码质量分析

- 安全漏洞检测

- 最佳实践建议

3. 自动化工作流

- 数据处理

- 批量数据转换

- 格式标准化

- 数据清洗

- 系统集成

- API 对接

- 服务编排

- 自动化脚本

通过 API易 快速接入

1. 基础配置

import openai

openai.api_base = "https://vip.apiyi.com/v1"

openai.api_key = "你的API易密钥"

# 基础调用示例

response = openai.ChatCompletion.create(

model="o3-mini",

messages=[

{"role": "system", "content": "你是一个专业的数学助手。"},

{"role": "user", "content": "请帮我解决这个方程:x² + 5x + 6 = 0"}

]

)

2. 函数调用示例

# 函数调用示例

response = openai.ChatCompletion.create(

model="o3-mini",

messages=[{"role": "user", "content": "计算今天的天气"}],

functions=[{

"name": "get_weather",

"description": "获取天气信息",

"parameters": {

"type": "object",

"properties": {

"location": {"type": "string"},

"unit": {"type": "string"}

}

}

}]

)

3. 批量处理示例

# 批量处理示例

async def process_batch(texts):

async with openai.AsyncOpenAI() as client:

responses = await asyncio.gather(*[

client.chat.completions.create(

model="o3-mini",

messages=[{"role": "user", "content": text}]

) for text in texts

])

return responses

性能优化建议

- 合理使用上下文

- 控制输入长度

- 清晰的指令描述

- 适当的系统提示

- 批量处理优化

- 合并相似请求

- 使用异步处理

- 实现请求队列

- 成本控制

- 使用低强度模式处理简单任务

- 缓存常用结果

- 优化 token 使用

为什么选择 API易

- 价格优势

- 与官方价格基本持平(API易充值角度约官网八折)

- 无最低消费限制

- 免费额度体验

- 服务保障

- 多节点部署

- 高并发支持

- 7×24技术支持

- 便捷接入

- OpenAI 兼容接口

- 详细技术文档

- 示例代码丰富

常见问题

1. 推理强度相关

Q: 不同推理强度有什么区别?

A: o3-mini 提供三个级别的推理强度:

- low:优化速度,适合简单任务

- medium:默认选项,平衡性能和速度

- high:增强推理能力,但有使用限制

Q: high 级别的使用限制是什么?

A: high 推理强度每周限制使用 50 次,建议只在关键任务中使用。

Q: 如何选择合适的推理强度?

A: 根据任务复杂度选择:

- 简单对话和基础任务:使用 low

- 日常开发和一般应用:使用 medium

- 复杂的 STEM 问题:使用 high

2. 连接问题

Q: 为什么有时连接失败?

A: 可能是网络问题或服务器维护,请检查网络连接或稍后再试。

Q: 如何解决连接问题?

A: 检查网络设置,确保设备可以访问互联网。如果问题持续存在,请联系 API易 技术支持团队。

总结

o3-mini 作为 OpenAI 最新推出的小型推理模型,在保持高性价比的同时,提供了丰富的开发者功能和出色的性能表现。通过 API易 平台,你可以快速接入这个强大的模型,实现各种高智能应用场景。无论是科学计算、代码开发还是自动化工作流,o3-mini 都能提供可靠的支持。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持 o3-mini 等全系列模型,让 AI 开发更简单

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。