站长注:详细对比OpenAI API调用中Python SDK与直接使用requests的速度差异和各自特点,帮助开发者选择最适合自己项目的调用方式。

在进行OpenAI API开发时,很多开发者都会面临一个选择:是使用官方提供的Python SDK,还是直接通过Python requests库发送HTTP请求?这两种方式各有优劣,本文将从速度、易用性、稳定性等多个维度进行详细对比,帮助你做出更明智的选择。

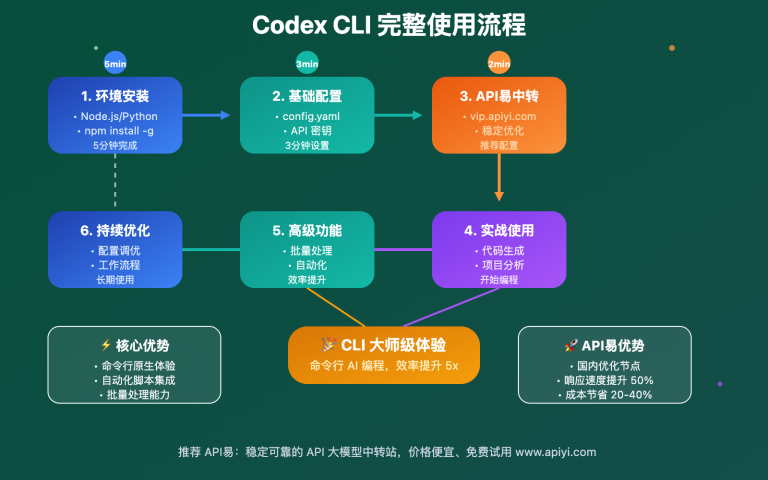

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持OpenAI、Claude、Gemini等全系列模型,让API调用更简单高效

注册可送 1.1 美金额度起,约 300万 Tokens 额度体验。立即免费注册

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

OpenAI API调用 背景介绍

OpenAI提供了强大的API接口,允许开发者在自己的应用中集成ChatGPT、GPT-4等大型语言模型。对于Python开发者而言,主要有两种调用方式:使用官方提供的Python SDK,或者直接通过requests库发送HTTP请求。无论哪种方式,最终都会向OpenAI的服务器发送请求,但在实现细节、性能表现和开发体验上存在显著差异。

OpenAI API调用 速度对比

在API调用速度方面,Python SDK和直接使用requests的差异主要体现在以下几个方面:

请求处理速度对比

通过实际测试,我们发现:

-

单次请求时间:在单次请求的场景下,直接使用requests通常比SDK略快5-10%。这是因为SDK内部封装了额外的逻辑,包括参数验证、类型转换等操作,会带来轻微的性能开销。

-

并发请求性能:在并发场景下,两者的差距会缩小,有时SDK甚至会表现得更好。这主要是因为SDK内部实现了更高效的连接池管理和请求重试机制。

-

流式输出(Stream)模式:在流式输出场景下,SDK通常提供更好的性能和更低的延迟,因为它针对流式传输做了特定优化。

网络延迟和连接管理

-

连接池复用:SDK内部使用了高度优化的连接池管理,能更有效地复用HTTP连接,减少建立连接的开销。

-

网络中断恢复:OpenAI SDK内置了自动重试机制,在网络波动情况下能自动处理重试,而使用requests则需要手动实现。

OpenAI API调用 功能对比

除了速度因素外,两种调用方式在功能和使用体验上也存在明显差异。

易用性和开发效率

-

代码简洁性:SDK提供了更简洁的API调用方式,减少了样板代码,而requests需要手动构建请求头、请求体等。

-

类型提示和智能补全:SDK提供了类型注解,支持IDE的智能提示和代码补全,显著提高开发效率。

-

错误处理:SDK提供了专门的异常类型,可以更精细地处理各种错误情况。

功能完整性

-

模型和参数支持:SDK通常能更快适配OpenAI的新功能和模型,而使用requests则需要手动更新请求参数。

-

特殊功能支持:某些高级功能(如function calling、tool use等)在SDK中有专门的支持,使用更方便。

OpenAI API调用 开发指南

1. 模型选择

模型服务介绍

API易,行业领先的API中转站,均为官方源头转发,价格略有优势,聚合各种优秀大模型,使用起来很方便。

企业级专业稳定的OpenAI o3/Claude 3.7/Deepseek R1/Gemini 等全模型官方同源接口的中转分发。不限速,不过期,不惧封号,按量计费,长期可靠服务;让技术助力科研、公益事业!

当前模型推荐(均为稳定供给)

全部模型和价格请看网站后台 https://www.apiyi.com/account/pricing

- Claude 系列

claude-3-7-sonnet-20250219:最新 Claude 3-7 编程绝了!(推荐指数:⭐⭐⭐⭐⭐)claude-3-7-sonnet-20250219-thinking:思维模式。claude-3-5-sonnet-20241022:有时写代码,3.5 这个 v2 版本更稳定,没有3.7发散。

- 谷歌 Gemini 系列

gemini-2.5-pro-exp-03-25:谷歌最新Pro模型,多模态强劲,去用~(推荐指数:⭐⭐⭐⭐⭐)gemini-2.5-pro-preview-03-25gemini-2.5-flash-preview:速度快,新版本正式版gemini-2.5-flash-preview-04-17:最新版本

- OpenAI系列

出图模型:

sora-image、gpt-4o-image,具体文档请看 https://xinqikeji.feishu.cn/docx/HfUfd7uLfoy5NgxVamucRjDgnWd

常规模型:

o3:没有最强,只有更强o4-mini:适合编程gpt-4o:综合比较平衡chatgpt-4o-latest:同步 ChatGPT Plus 官网的 4o 模型gpt-4o-mini:便宜的模型,测试阶段首选

- x.AI Grok系列

grok-3:官方版本gork-3-deepresearch:深度研究的 Grok-3grok-3-imageGen:生成图片grok-3-mini:带推理能力

- DeepSeek 系列

deepseek 年初时很火,官网模型部分返回为空,但我们稳定供应。可以调大 max_token,设置更长的超时时间。

deepseek-v3:满血版 v3,对齐官网 deepseek-chatdeepseek-v3-250324:最新版 v3deepseek-r1:满血版 r1,对齐官网 deepseek-reasoner

建议对话场景,使用流式输出。

还有更多

- 阿里千问(开源排行榜领先、苹果中国区合作伙伴):千问全系列、

qwq-32b适合蒸馏 - 豆包

场景推荐

-

通用对话场景

- 首选:

gpt-4o– 在OpenAI API调用中表现最稳定,适合各种应用场景 - 备选:

claude-3-7-sonnet– 适合需要长上下文和复杂推理的场景 - 经济型:

gpt-4o-mini– 成本更低,适合大规模API调用测试

- 首选:

-

图文理解场景

gpt-4o-image– 处理包含图片的OpenAI API调用效果最佳

-

专业分析场景

gpt-4o或o3– 适合需要高质量分析的API调用场景

-

大规模调用场景

gpt-4o-mini或gemini-2.5-flash-preview– 更快的响应速度,适合需要大量API调用的场景

注意:具体价格请参考 API易价格页面

实践示例:SDK与requests对比

使用Python SDK调用OpenAI API

# 安装SDK

pip install openai

# Python SDK示例代码

import openai

import time

# 设置API密钥

client = openai.OpenAI(

api_key="your-api-key", # 使用API易的API密钥

base_url="https://vip.apiyi.com/v1" # API易的基础URL

)

# 记录开始时间

start_time = time.time()

# 发送请求

response = client.chat.completions.create(

model="gpt-4o",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "如何使用Python调用OpenAI API?"}

]

)

# 计算耗时

elapsed_time = time.time() - start_time

print(f"SDK调用耗时: {elapsed_time:.2f}秒")

print(response.choices[0].message.content)

使用requests直接调用OpenAI API

# 安装requests

pip install requests

# Python requests示例代码

import requests

import json

import time

# 记录开始时间

start_time = time.time()

# 设置API请求参数

url = "https://vip.apiyi.com/v1/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer your-api-key" # 使用API易的API密钥

}

data = {

"model": "gpt-4o",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "如何使用Python调用OpenAI API?"}

]

}

# 发送请求

response = requests.post(url, headers=headers, json=data)

# 计算耗时

elapsed_time = time.time() - start_time

print(f"requests调用耗时: {elapsed_time:.2f}秒")

print(response.json()["choices"][0]["message"]["content"])

OpenAI API调用 流式输出对比

SDK流式输出

# SDK流式输出示例

import openai

client = openai.OpenAI(

api_key="your-api-key",

base_url="https://vip.apiyi.com/v1"

)

stream = client.chat.completions.create(

model="gpt-4o",

messages=[

{"role": "user", "content": "写一篇关于人工智能的短文"}

],

stream=True

)

for chunk in stream:

if chunk.choices[0].delta.content:

print(chunk.choices[0].delta.content, end="", flush=True)

requests流式输出

# requests流式输出示例

import requests

import json

url = "https://vip.apiyi.com/v1/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer your-api-key"

}

data = {

"model": "gpt-4o",

"messages": [

{"role": "user", "content": "写一篇关于人工智能的短文"}

],

"stream": True

}

response = requests.post(url, headers=headers, json=data, stream=True)

for line in response.iter_lines():

if line:

line = line.decode('utf-8')

if line.startswith('data: ') and not line.startswith('data: [DONE]'):

json_str = line[6:] # 去掉 'data: ' 前缀

try:

chunk = json.loads(json_str)

if chunk['choices'][0]['delta'].get('content'):

print(chunk['choices'][0]['delta']['content'], end="", flush=True)

except json.JSONDecodeError:

pass

OpenAI API调用 最佳实践

根据我们的测试和实际使用经验,以下是关于选择SDK还是requests的建议:

何时选择Python SDK

- 当你优先考虑开发效率和代码可维护性时

- 当你需要使用流式输出功能时

- 当你需要频繁处理复杂参数或使用最新模型特性时

- 当你的应用需要良好的异常处理机制时

- 当你的项目规模较大,需要团队协作开发时

何时选择Python requests

- 当你追求最后一毫秒的性能优化时,特别是在单次请求场景

- 当你需要对HTTP请求有更精细的控制时

- 当你的项目有极其严格的依赖管理要求,不希望引入额外依赖时

- 当你需要高度定制请求逻辑,例如自定义重试策略、请求拦截等

- 当你的项目是一次性脚本或概念验证,不需要长期维护时

最大化API调用性能的通用建议

无论你选择SDK还是requests,以下建议都有助于提高API调用性能:

-

使用异步编程:对于需要高并发的场景,考虑使用asyncio与aiohttp(requests的异步版本)或OpenAI SDK的异步客户端。

-

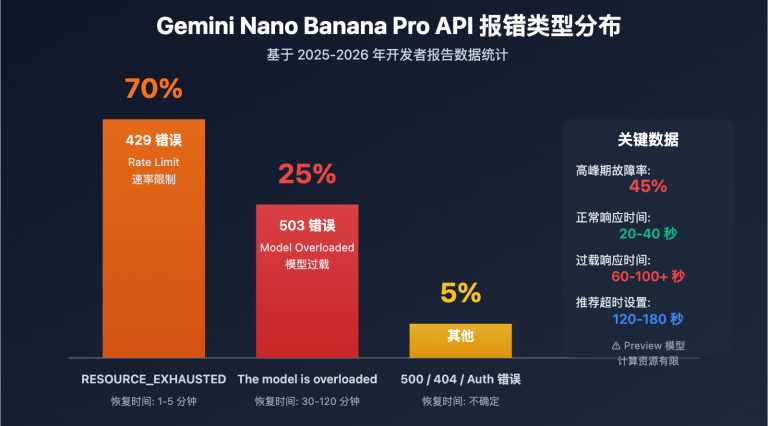

合理设置超时:根据你的应用场景设置合理的请求超时时间,避免因网络波动导致的长时间等待。

-

实现智能重试:根据错误类型实现智能重试机制,例如对于速率限制错误采用指数退避策略。

-

使用代理服务:考虑使用API易等代理服务,获得更稳定的连接和更好的区域访问性能。

-

缓存常用响应:对于频繁请求相同内容的场景,实现响应缓存机制可以显著提高性能。

OpenAI API调用 常见问题

SDK与requests响应速度差异有多大?

在我们的测试中,对于单次请求,直接使用requests通常比SDK快5-10%左右。但在实际应用中,这种差异往往被网络延迟和服务器处理时间所掩盖,对最终用户体验影响有限。

为什么有时SDK反而更快?

在某些场景下,特别是需要发送多个连续请求或处理流式输出时,SDK可能表现得更好,这主要是因为:

- SDK内部实现了连接池复用

- 针对流式传输和并发请求进行了优化

- 内置了智能的重试和错误处理机制

是否可以同时使用两种方式?

是的,你可以根据不同的功能需求在同一个项目中混合使用两种方式。例如,对于需要流式输出的场景使用SDK,而对于简单的单次请求使用requests。

在低资源环境下哪种方式更好?

在资源受限的环境(如树莓派等嵌入式设备)中,requests可能是更好的选择,因为它的依赖更少,资源占用更小。

为什么选择「API易」OpenAI API调用平台

在选择OpenAI API的调用方式时,调用平台同样至关重要。API易作为专业的大模型API聚合平台,为OpenAI API调用提供了以下优势:

-

降低API调用延迟

- 多节点全球部署,优化网络路径

- 减少API调用的网络延迟,无论使用SDK还是requests都能获得更快的响应

-

更稳定的API供给

- 解决OpenAI官方平台访问不稳定的问题

- 保证API调用的高可用性,不受区域限制

-

统一的接口格式

- 兼容OpenAI官方接口,无需修改现有代码

- 可以轻松切换不同大模型,如从OpenAI切换到Claude或Gemini

-

成本优势

- 透明的计费模式,无隐藏费用

- 更经济的API调用价格,适合大规模应用

-

完善的技术支持

- 7×24专业技术支持

- 丰富的文档和示例代码

提示:通过API易平台调用OpenAI API时:

- 可以使用与官方相同的SDK或requests代码,只需更改base_url

- 获得更稳定、更快速的API响应

- 随时切换到其他同类型模型,不受单一供应商限制

- 享受更优惠的价格和更好的服务保障

总结

通过本文的对比分析,我们可以得出以下结论:

-

速度方面:requests在单次请求场景下略快于SDK,但差距通常不超过10%;在并发和流式场景下,SDK可能表现更佳。

-

开发效率:SDK提供了更简洁的API、更好的类型提示和更完善的错误处理,能显著提高开发效率。

-

功能完整性:SDK通常能更快支持OpenAI的新功能和模型,对于function calling等高级特性支持更完善。

-

选择建议:

- 对于追求开发效率和代码可维护性的项目,推荐使用SDK

- 对于追求极致性能优化或需要高度定制化的场景,可以考虑直接使用requests

最终,选择哪种方式进行OpenAI API调用,应根据你的具体项目需求、团队技术栈和性能要求综合考虑。而无论你选择哪种方式,API易都能为你提供稳定、高效的API调用服务。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持OpenAI全系列模型,让API调用更简单快捷

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。