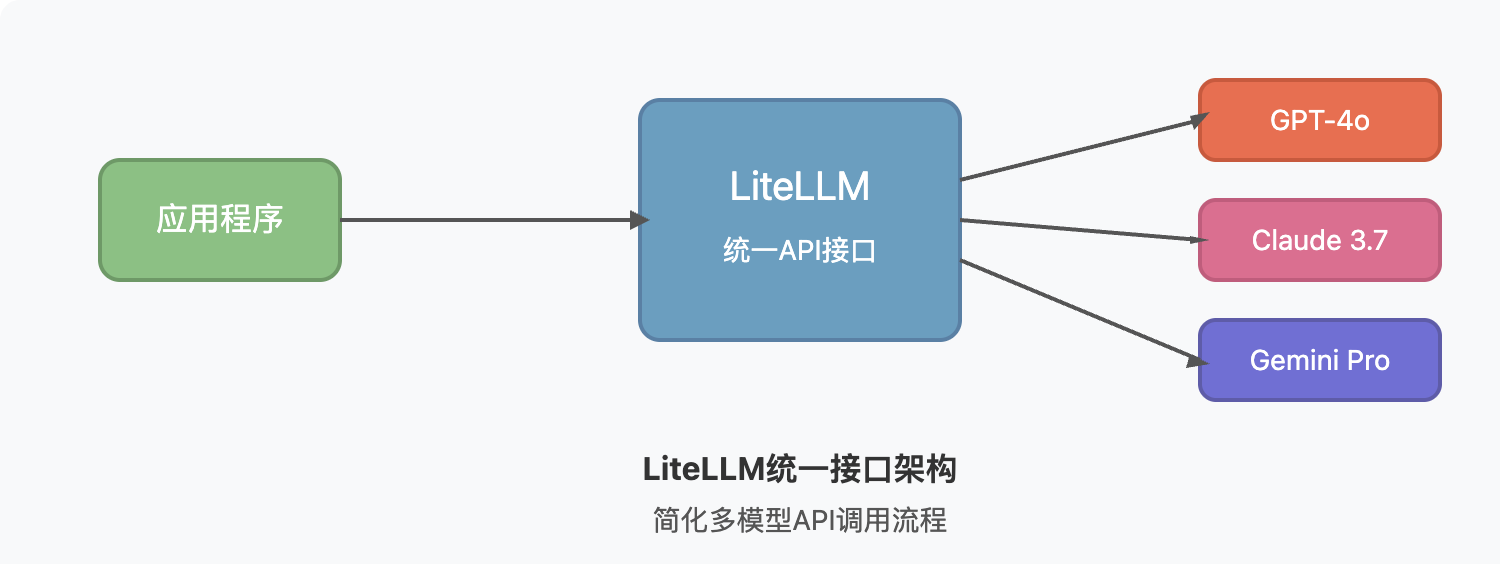

站长注:详解LiteLLM开源库与API易中转站集成方案,轻松实现100+大模型的统一管理与调用

在大模型API日新月异的今天,开发者往往需要同时对接多家模型服务,管理复杂的API接口和密钥。LiteLLM作为一款强大的开源工具,提供了统一调用多种大模型的解决方案,而结合API易中转站使用,更能解锁强大的模型聚合与管理能力。本文将深入介绍LiteLLM及其与API易的完美集成方案。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持Claude 3.7、GPT-4o、Deepseek等100+全系列模型,无需国外信用卡,轻松接入

注册可送 1.1 美金额度起,约 300万 Tokens 额度体验。立即免费注册

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

LiteLLM背景介绍

LiteLLM是一个开源的Python库和代理服务器,旨在提供统一的接口来与100多种大型语言模型进行交互。它通过OpenAI兼容格式,简化了不同模型API的集成复杂性,为开发者提供一致的开发体验。

LiteLLM的出现解决了AI开发中的几个关键痛点:

- API格式碎片化:各家大模型供应商使用不同的API结构和格式

- 重复开发成本:为每个模型编写特定的接口代码耗时费力

- 供应商锁定风险:业务过度依赖单一模型提供商

- 跨模型测试困难:难以在不同模型间进行性能比较

作为"大模型的统一翻译器",LiteLLM可以让应用程序通过一个一致的接口与任何支持的语言模型通信,同时保持输出格式的一致性,大大降低了开发和维护成本。

LiteLLM核心功能

LiteLLM Python SDK功能

LiteLLM的Python SDK为开发者提供了丰富的功能:

- 统一接口访问:通过一套API访问100+种大语言模型

- 重试/故障转移逻辑:支持在多个部署之间实现自动重试和故障转移

- 一致的输出格式:无论使用哪种模型,输出格式始终保持一致,文本响应总是位于

['choices']['message']['content'] - 支持多种任务类型:支持completion、embedding和image generation等多种端点

LiteLLM代理服务器功能

作为一个中央LLM网关服务,LiteLLM代理服务器提供:

- 集中式模型管理:统一管理多个LLM访问权限

- 使用追踪:监控不同项目和模型的使用情况

- 自定义配置:为每个项目提供定制化的日志记录、防护栏和缓存

- 支出跟踪:跟踪花费并为每个项目设置预算

LiteLLM应用场景

LiteLLM在多种AI开发场景中展现出强大的价值:

- 模型评估与比较:轻松切换不同模型进行性能对比,无需更改代码

- 多模型应用:根据不同任务特点自动选择最合适的模型

- 降低供应商依赖:快速替换模型供应商,避免锁定风险

- 统一监控平台:集中管理所有模型调用的日志、成本和性能

- AI应用原型快速开发:使用统一接口加速开发流程

LiteLLM开发指南

1. 模型选择

模型服务介绍

API易,行业领先的API中转站,均为官方源头转发,价格略有优势,聚合各种优秀大模型,使用起来很方便。

企业级专业稳定的OpenAI o3/Claude 3.7/Deepseek R1/Gemini 等全模型官方同源接口的中转分发。不限速,不过期,不惧封号,按量计费,长期可靠服务;让技术助力科研、公益事业!

当前模型推荐(均为稳定供给)

通过LiteLLM结合API易,可以访问以下热门模型:

-

Claude系列

claude-3-7-sonnet-20250219:最新Claude 3.7 编程绝了!(推荐指数:⭐⭐⭐⭐⭐)claude-3-5-sonnet-20241022:稳定的3.5版本,编程能力强

-

OpenAI系列

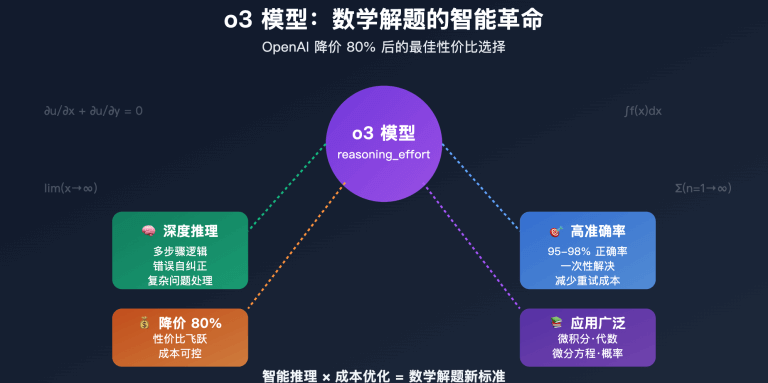

o3:OpenAI最新强力模型gpt-4o:综合性能优异gpt-4o-mini:经济型选择,测试阶段首选

-

谷歌Gemini系列

gemini-2.5-pro-preview-05-06:谷歌最新Pro模型,多模态能力出色(推荐指数:⭐⭐⭐⭐⭐)gemini-2.5-flash-preview:速度快,新版本正式版

-

DeepSeek系列

deepseek-v3:满血版v3,对齐官网deepseek-chatdeepseek-r1:满血版r1,推理能力强

场景推荐

-

通用对话场景

- 首选:

claude-3-7-sonnet-20250219(平衡能力与成本) - 备选:

gpt-4o(强大的通用能力) - 经济型:

gpt-4o-mini(性价比高)

- 首选:

-

图文理解场景

- 首选:

gemini-2.5-pro-preview-05-06(多模态强项) - 备选:

gpt-4o(图像理解能力出色)

- 首选:

-

专业编程场景

- 首选:

claude-3-7-sonnet-20250219(编程表现优异) - 备选:

deepseek-r1(代码生成能力强)

- 首选:

-

大规模调用场景

- 首选:

gpt-4o-mini(成本效益好) - 备选:

gemini-2.5-flash-preview(速度快,价格优)

- 首选:

注意:具体价格请参考 API易价格页面

2. LiteLLM基础安装与配置

首先,通过pip安装LiteLLM:

pip install litellm

3. 使用LiteLLM连接API易

3.1 基本设置

import os

from litellm import completion

# 设置环境变量

os.environ["APIYI_API_KEY"] = "你的API易API密钥"

os.environ["OPENAI_API_BASE"] = "https://vip.apiyi.com/v1" # API易的OpenAI兼容接口

# 发送请求示例

response = completion(

model="gpt-4o", # 使用API易提供的gpt-4o模型

messages=[{"role": "user", "content": "你好,请介绍一下自己"}]

)

print(response.choices[0].message.content)

3.2 使用不同模型

LiteLLM支持通过model参数轻松切换不同模型:

# 使用Claude 3.7模型

response_claude = completion(

model="claude-3-7-sonnet-20250219",

messages=[{"role": "user", "content": "解释量子力学的基本原理"}]

)

# 使用Gemini模型

response_gemini = completion(

model="gemini-2.5-pro-preview-05-06",

messages=[{"role": "user", "content": "分析人工智能的未来发展趋势"}]

)

3.3 高级功能:路由与负载均衡

LiteLLM支持在多个模型之间进行智能路由和负载均衡:

from litellm import Router

# 配置路由器

router = Router(

model_list=[

{

"model_name": "gpt-4o",

"litellm_params": {

"model": "gpt-4o",

"api_key": "你的API易API密钥",

"api_base": "https://vip.apiyi.com/v1"

},

"tier": "high"

},

{

"model_name": "claude-3-7-sonnet",

"litellm_params": {

"model": "claude-3-7-sonnet-20250219",

"api_key": "你的API易API密钥",

"api_base": "https://vip.apiyi.com/v1"

},

"tier": "high"

},

{

"model_name": "gpt-4o-mini",

"litellm_params": {

"model": "gpt-4o-mini",

"api_key": "你的API易API密钥",

"api_base": "https://vip.apiyi.com/v1"

},

"tier": "medium"

}

],

fallbacks=[

{

"high": "medium" # 如果高层级模型失败,回退到中层级模型

}

]

)

# 使用路由器发送请求

response = router.completion(

model="gpt-4o", # 这将使用路由规则选择合适的模型

messages=[{"role": "user", "content": "编写一个Python函数来计算斐波那契数列"}]

)

4. 部署LiteLLM代理服务器

使用以下配置部署LiteLLM代理服务器,与API易集成:

# 创建配置文件

cat > config.yaml << EOL

model_list:

- model_name: gpt-4o

litellm_params:

model: gpt-4o

api_base: https://vip.apiyi.com/v1

api_key: 你的API易API密钥

- model_name: claude-3-7-sonnet

litellm_params:

model: claude-3-7-sonnet-20250219

api_base: https://vip.apiyi.com/v1

api_key: 你的API易API密钥

- model_name: gemini-pro

litellm_params:

model: gemini-2.5-pro-preview-05-06

api_base: https://vip.apiyi.com/v1

api_key: 你的API易API密钥

# 路由规则

router_settings:

routing_strategy: usage_based # 基于使用情况选择模型

# 日志配置

log_settings:

console_log_level: info

EOL

# 启动LiteLLM代理服务器

litellm --config config.yaml --port 8000

启动后,你可以通过本地API使用代理服务器:

import openai

client = openai.Client(

api_key="任意字符串", # LiteLLM代理服务器可以使用任意API密钥

base_url="http://localhost:8000/v1"

)

# 调用模型

response = client.chat.completions.create(

model="gpt-4o", # 使用在config.yaml中配置的模型

messages=[{"role": "user", "content": "创建一个电子商务网站的架构设计"}]

)

print(response.choices[0].message.content)

LiteLLM最佳实践

LiteLLM接入API易最佳实践

-

利用环境变量管理API密钥

# 推荐做法 import os os.environ["APIYI_API_KEY"] = "你的密钥" # 避免硬编码API密钥 -

实现优雅的错误处理

from litellm import completion import litellm try: response = completion(...) except litellm.exceptions.ServiceUnavailableError: # 处理服务不可用错误 pass except litellm.exceptions.InvalidRequestError: # 处理无效请求错误 pass except Exception as e: # 处理其他异常 print(f"发生错误:{str(e)}") -

实现模型自动回退机制

配置多个模型,并在首选模型失败时自动尝试备选模型。 -

使用流式响应提升用户体验

for chunk in completion( model="gpt-4o", messages=[{"role": "user", "content": "写一篇短文"}], stream=True ): print(chunk.choices[0].delta.content or "", end="") -

设置合理的超时和重试策略

response = completion( model="claude-3-7-sonnet-20250219", messages=[...], timeout=30, # 30秒超时 max_retries=3 # 最多重试3次 )

LiteLLM常见问题

为什么我的API调用返回错误?

最常见的错误原因包括API密钥无效、请求格式不正确或超出了速率限制。请检查API密钥是否正确设置,并确保请求参数符合要求。

如何在多个项目中共享LiteLLM配置?

可以创建一个共享的配置文件,并在多个项目中引用该文件。或者,使用LiteLLM代理服务器作为中央服务,让所有项目通过该服务访问模型。

LiteLLM能否跟踪API使用成本?

是的,LiteLLM可以跟踪API调用的使用成本。您可以使用litellm.track_cost功能或在代理服务器中配置成本跟踪。

如何保证API调用的安全性?

建议使用环境变量或安全的密钥管理系统存储API密钥,而不是硬编码在代码中。此外,可以在LiteLLM代理服务器中配置访问控制和速率限制。

LiteLLM支持哪些模型?

LiteLLM支持100多种大型语言模型,包括OpenAI的GPT系列、Anthropic的Claude系列、Google的Gemini系列以及众多开源模型。通过API易,您可以访问所有这些主流模型。

为什么选择「API易」AI大模型API聚合平台

在与LiteLLM集成时,API易能提供以下核心优势:

-

稳定可靠的模型供给

- 解决多家模型官方平台的充值和访问限制问题

- 无需海外信用卡或特殊网络环境

- API易确保所有模型的持续稳定供给

-

丰富的模型兼容性

- 完美兼容LiteLLM支持的所有主流模型

- 与LiteLLM的统一接口理念完全契合

- 通过一个API易账户即可接入所有模型

-

简化的开发流程

- 使用API易的OpenAI兼容接口,大幅降低LiteLLM配置复杂度

- 只需更改base_url和api_key即可完成所有模型的接入

-

成本优势

- 透明定价,无隐藏费用

- 按量计费,不用担心预付费额度过期

- 与直接对接各家官方相比有价格优势

提示:使用LiteLLM+API易的组合,你可以:

- 通过统一接口调用所有主流大模型

- 实现智能路由和负载均衡

- 无需处理多家厂商的账号和充值

- 享受API易提供的专业技术支持

总结

LiteLLM作为大模型调用的统一接口,大大简化了多模型集成的复杂性。通过与API易的结合,开发者可以轻松获取所有主流大语言模型的访问权限,而无需处理不同平台的账号申请、充值限制和API差异。

无论是构建多模型应用、进行模型性能评估,还是降低供应商依赖风险,LiteLLM+API易的组合都能提供理想的解决方案。通过本文提供的集成指南和最佳实践,您可以快速构建基于多种先进大模型的强大AI应用。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持Claude 3.7、GPT-4o、Deepseek等100+全系列模型接入LiteLLM,无缝衔接

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。