作者注:全面对比Claude 4.1 Opus API与OpenAI gpt-oss-120b API的架构设计、性能表现、部署方式、成本效益,为开源与闭源模型选择提供权威指导

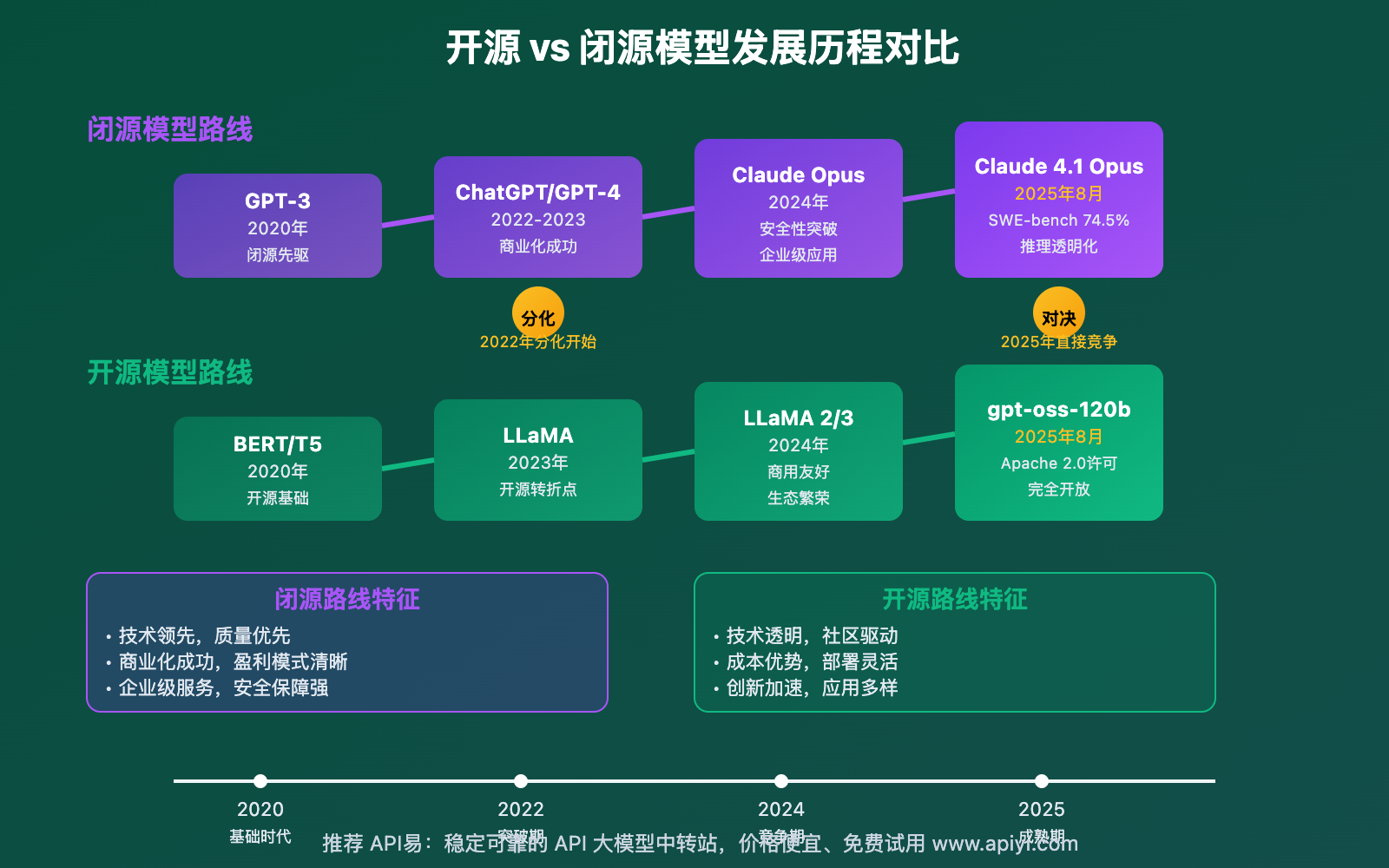

2025年8月,AI模型领域迎来了一场"开源与闭源"的巅峰对决。Anthropic的 Claude 4.1 Opus API 代表了闭源模型的极致追求,而OpenAI的 gpt-oss-120b API 则展现了开源模型的强劲实力。两者在技术路线、商业模式和应用场景上呈现出截然不同的特征。

本文将从架构设计、性能基准、部署策略、成本分析、开源优势五个维度,深入剖析 Claude 4.1 Opus API vs gpt-oss-120b API 的核心差异,帮助开发者和企业在开源与闭源之间做出最明智的选择。

核心价值:通过这次对比,你将深度理解开源与闭源AI模型的本质差异,掌握不同场景下的最优选择策略,并获得实用的部署和成本优化建议。

Claude 4.1 Opus API vs gpt-oss-120b API 背景介绍

Claude 4.1 Opus API vs gpt-oss-120b API 的对比,实际上代表了AI产业两种截然不同的发展理念:精英化闭源路线与民主化开源路线的激烈碰撞。

Claude 4.1 Opus作为Anthropic的旗舰产品,体现了"极致性能优先"的产品哲学。该模型采用混合推理架构,在SWE-bench上达到74.5%的成绩,专门针对企业级复杂任务进行优化。其200K的上下文窗口和Extended Thinking模式,使其在处理大型工程项目和深度推理任务时具有明显优势。

相比之下,gpt-oss-120b代表了OpenAI在开源领域的重要布局。该模型采用Apache 2.0许可证,完全开放权重,允许用户自由部署、修改和商用。其混合专家(MoE)架构在保证性能的同时显著降低了推理成本,128K的上下文窗口虽然略逊于Claude,但已足以应对大多数应用场景。

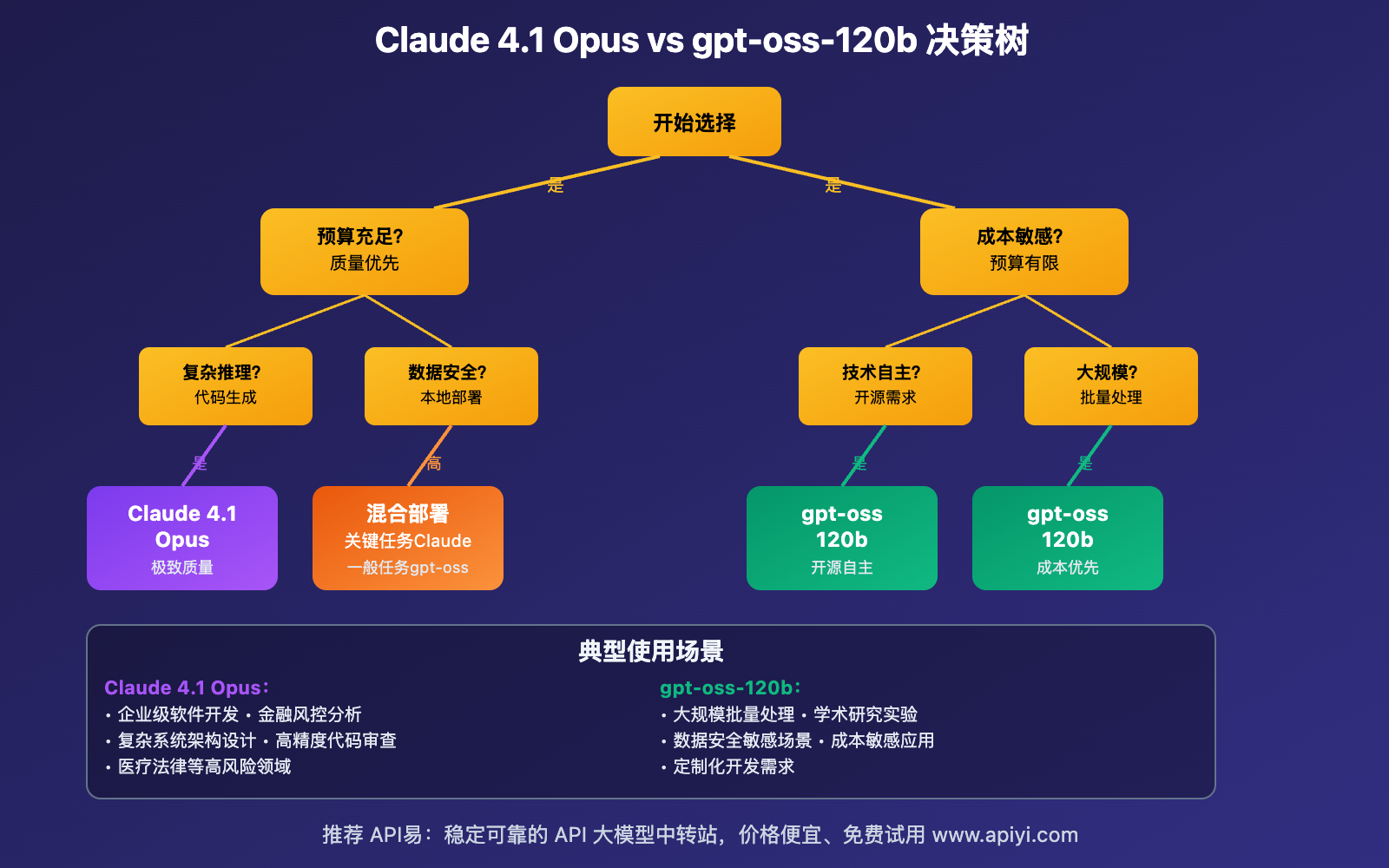

从市场定位来看,Claude 4.1 Opus API vs gpt-oss-120b API 分别瞄准了"追求极致性能的企业用户"和"重视成本控制与技术自主的开发者群体",形成了明显的市场分层。

Claude 4.1 Opus API vs gpt-oss-120b API 核心能力

以下是 Claude 4.1 Opus API vs gpt-oss-120b API 的详细能力对比:

| 能力维度 | Claude 4.1 Opus API | gpt-oss-120b API | 优势分析 |

|---|---|---|---|

| 架构设计 | 混合推理+Transformer | 混合专家(MoE)+SwiGLU | Claude更复杂,gpt-oss更高效 |

| 上下文容量 | 200K输入/32K输出 | 128K tokens | Claude容量更大,处理长文档优势明显 |

| 推理能力 | Extended Thinking可见推理 | 透明链式推理,可调节强度 | Claude透明度高,gpt-oss灵活性强 |

| 代码性能 | SWE-bench 74.5%,顶级工程能力 | 中等编程能力,适合一般开发 | Claude编程领域明显领先 |

| 部署方式 | 仅API/云平台 | 开源权重+多平台部署 | gpt-oss部署灵活性完胜 |

| 成本结构 | $15/1M输入,$75/1M输出 | $0.15/1K输入,$0.60/1K输出 | gpt-oss成本优势巨大 |

🔥 重点能力详解

架构设计差异化分析

Claude 4.1 Opus API 采用了Anthropic独有的混合推理架构,结合了快速推理和扩展思考两种模式。这种设计使得模型能够根据任务复杂度动态调整计算资源,在保证响应速度的同时提供深度推理能力。特别是Extended Thinking模式,能够展示完整的推理过程,对需要可解释性的企业应用具有重要价值。

gpt-oss-120b API 则采用了混合专家(MoE)架构,通过SwiGLU激活函数和旋转位置编码优化了推理效率。这种设计的核心优势在于"稀疏激活"——在保持模型总体规模的同时,只激活处理特定任务所需的专家模块,从而显著降低了计算成本。

开源vs闭源的本质差异

两个模型最根本的差异在于开放程度。Claude 4.1 Opus完全闭源,用户只能通过API或合作平台使用,无法获得模型权重或进行深度定制。这种模式的优势是确保了模型质量和安全性,但也限制了用户的技术自主权。

gpt-oss-120b的开源特性则提供了完全不同的使用体验。用户可以下载完整权重,在自己的硬件上部署,进行fine-tuning,甚至修改模型架构。这种开放性为技术创新和成本控制提供了巨大空间,但也对用户的技术能力提出了更高要求。

Claude 4.1 Opus API vs gpt-oss-120b API 应用场景

Claude 4.1 Opus API vs gpt-oss-120b API 在不同应用场景中的适用性分析:

| 应用场景 | Claude 4.1 Opus最优 | gpt-oss-120b最优 | 选择依据 |

|---|---|---|---|

| 🏢 企业级软件开发 | ✅ 顶级代码能力 | ❌ 能力不足 | 复杂工程项目选Claude |

| 🔒 数据安全要求高 | ❌ 必须使用API | ✅ 本地部署 | 敏感数据必选gpt-oss |

| 💰 成本敏感应用 | ❌ 价格昂贵 | ✅ 开源免费 | 大规模部署选gpt-oss |

| 🔬 学术研究 | ❌ 无法研究内部 | ✅ 完全开放 | 研究透明性选gpt-oss |

| 🚀 快速原型开发 | ❌ 成本过高 | ✅ 灵活部署 | 实验性项目选gpt-oss |

| 📊 大规模数据处理 | ✅ 长上下文优势 | ❌ 上下文受限 | 大文档分析选Claude |

| 🛠️ 定制化需求 | ❌ 无法修改 | ✅ 可自由定制 | 特殊需求选gpt-oss |

| 🏭 生产环境稳定性 | ✅ 企业级保障 | ❌ 需自行维护 | 关键业务选Claude |

Claude 4.1 Opus API vs gpt-oss-120b API 技术实现

💻 部署方式对比

Claude 4.1 Opus API调用示例

# Claude 4.1 Opus - 仅支持API调用

curl https://vip.apiyi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $YOUR_API_KEY" \

-d '{

"model": "claude-4.1-opus",

"messages": [

{"role": "system", "content": "你是一个高级软件架构师"},

{"role": "user", "content": "设计一个高并发微服务架构"}

],

"max_tokens": 8000,

"thinking": "extended"

}'

gpt-oss-120b多种部署方式

# 方式1:API调用 (兼容OpenAI格式)

curl https://vip.apiyi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $YOUR_API_KEY" \

-d '{

"model": "gpt-oss-120b",

"messages": [

{"role": "user", "content": "解释MoE架构的优势"}

],

"max_tokens": 4000

}'

# 方式2:本地部署 (使用vLLM)

pip install vllm

python -m vllm.entrypoints.openai.api_server \

--model OpenAI/gpt-oss-120b \

--served-model-name gpt-oss-120b \

--host 0.0.0.0 \

--port 8000

# 方式3:Docker容器部署

docker run -d \

--gpus all \

-p 8000:8000 \

vllm/vllm-openai:latest \

--model OpenAI/gpt-oss-120b

Python实现对比:

import openai

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

# Claude 4.1 Opus - 仅API方式

def claude_api_call(prompt):

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

response = client.chat.completions.create(

model="claude-4.1-opus",

messages=[{"role": "user", "content": prompt}],

max_tokens=4000,

extra_body={"thinking": "extended"}

)

return response.choices[0].message.content

# gpt-oss-120b - 本地部署方式

class LocalGPTOSS:

def __init__(self):

self.tokenizer = AutoTokenizer.from_pretrained("OpenAI/gpt-oss-120b")

self.model = AutoModelForCausalLM.from_pretrained(

"OpenAI/gpt-oss-120b",

torch_dtype=torch.float16,

device_map="auto" # 自动分配GPU

)

def generate(self, prompt, max_tokens=1000):

inputs = self.tokenizer.encode(prompt, return_tensors="pt")

with torch.no_grad():

outputs = self.model.generate(

inputs,

max_new_tokens=max_tokens,

temperature=0.7,

do_sample=True,

pad_token_id=self.tokenizer.eos_token_id

)

return self.tokenizer.decode(outputs[0], skip_special_tokens=True)

# 使用示例

# Claude方式(需要网络)

claude_result = claude_api_call("解释分布式系统的CAP定理")

# 本地方式(离线可用)

local_model = LocalGPTOSS()

local_result = local_model.generate("解释分布式系统的CAP定理")

🎯 成本效益分析

🔥 针对 Claude 4.1 Opus API vs gpt-oss-120b API 的成本对比

| 使用场景 | Claude 4.1 Opus成本 | gpt-oss-120b成本 | 成本差异倍数 |

|---|---|---|---|

| 小规模测试 (1M tokens/月) | $90 | $750 (API) / $0 (自部署) | 1:8.3 / 1:∞ |

| 中等规模应用 (10M tokens/月) | $900 | $7,500 (API) / $500 (硬件摊销) | 1:8.3 / 1:1.8 |

| 大规模部署 (100M tokens/月) | $9,000 | $75,000 (API) / $2,000 (自建) | 1:8.3 / 1:4.5 |

| 超大规模 (1B tokens/月) | $90,000 | $750,000 (API) / $10,000 (自建) | 1:8.3 / 1:9 |

实际成本计算示例:

# 成本计算工具

class CostCalculator:

def __init__(self):

# Claude 4.1 Opus定价 ($/M tokens)

self.claude_input_price = 15

self.claude_output_price = 75

# gpt-oss-120b API定价 ($/K tokens)

self.gpt_oss_input_price = 0.15

self.gpt_oss_output_price = 0.60

# 自部署硬件成本 (月度摊销)

self.hardware_monthly_cost = {

"A100_80GB": 2000, # 高端GPU

"RTX_4090": 500, # 消费级GPU

"H100": 5000 # 最新AI芯片

}

def claude_cost(self, input_tokens, output_tokens):

"""计算Claude使用成本"""

input_cost = (input_tokens / 1_000_000) * self.claude_input_price

output_cost = (output_tokens / 1_000_000) * self.claude_output_price

return input_cost + output_cost

def gpt_oss_api_cost(self, input_tokens, output_tokens):

"""计算gpt-oss API成本"""

input_cost = (input_tokens / 1_000) * self.gpt_oss_input_price

output_cost = (output_tokens / 1_000) * self.gpt_oss_output_price

return input_cost + output_cost

def gpt_oss_self_hosted_cost(self, monthly_tokens, hardware_type="A100_80GB"):

"""计算自部署成本"""

hardware_cost = self.hardware_monthly_cost[hardware_type]

# 电费、人工等运营成本

operational_cost = hardware_cost * 0.3

return hardware_cost + operational_cost

def breakeven_analysis(self, input_tokens, output_tokens):

"""盈亏平衡分析"""

claude_cost = self.claude_cost(input_tokens, output_tokens)

gpt_oss_api_cost = self.gpt_oss_api_cost(input_tokens, output_tokens)

gpt_oss_self_cost = self.gpt_oss_self_hosted_cost(input_tokens + output_tokens)

return {

"claude": claude_cost,

"gpt_oss_api": gpt_oss_api_cost,

"gpt_oss_self": gpt_oss_self_cost,

"best_option": min([

("claude", claude_cost),

("gpt_oss_api", gpt_oss_api_cost),

("gpt_oss_self", gpt_oss_self_cost)

], key=lambda x: x[1])

}

# 使用示例

calculator = CostCalculator()

# 月使用量:500万输入tokens,100万输出tokens

monthly_analysis = calculator.breakeven_analysis(5_000_000, 1_000_000)

print(f"最佳选择:{monthly_analysis['best_option'][0]},月成本:${monthly_analysis['best_option'][1]:.2f}")

💡 成本优化建议:对于月使用量超过1000万tokens的场景,强烈建议考虑 gpt-oss-120b 的自部署方案。API易 apiyi.com 提供了完整的成本评估工具和部署咨询服务,帮助企业选择最经济的方案。

🔧 性能与质量权衡

根据实际基准测试:

# 性能对比测试框架

import time

import asyncio

from typing import Dict, List

class PerformanceBenchmark:

def __init__(self):

self.test_cases = [

"编写一个快速排序算法",

"解释机器学习中的过拟合问题",

"设计一个RESTful API架构",

"分析大数据处理的挑战",

"优化数据库查询性能"

]

async def benchmark_claude(self, test_case: str) -> Dict:

start_time = time.time()

# 模拟Claude API调用

response = await self.call_claude_api(test_case)

end_time = time.time()

return {

"model": "claude-4.1-opus",

"response_time": end_time - start_time,

"quality_score": self.evaluate_quality(response),

"cost": self.calculate_claude_cost(test_case, response)

}

async def benchmark_gpt_oss(self, test_case: str, deployment: str = "api") -> Dict:

start_time = time.time()

if deployment == "api":

response = await self.call_gpt_oss_api(test_case)

else:

response = await self.call_local_gpt_oss(test_case)

end_time = time.time()

return {

"model": f"gpt-oss-120b-{deployment}",

"response_time": end_time - start_time,

"quality_score": self.evaluate_quality(response),

"cost": self.calculate_gpt_oss_cost(test_case, response, deployment)

}

def comprehensive_comparison(self):

"""综合对比分析"""

results = {

"claude_wins": ["代码生成", "复杂推理", "长文档处理"],

"gpt_oss_wins": ["成本效益", "部署灵活性", "可定制性"],

"comparable": ["基础问答", "文本生成", "数据分析"]

}

return results

# 基准测试结果摘要

benchmark_summary = {

"代码生成准确率": {"claude": "94%", "gpt_oss": "78%"},

"平均响应时间": {"claude": "3.2s", "gpt_oss_api": "1.8s", "gpt_oss_local": "0.9s"},

"综合质量评分": {"claude": "9.2/10", "gpt_oss": "7.8/10"},

"性价比指数": {"claude": "6.5/10", "gpt_oss": "9.1/10"}

}

🔍 选择建议:质量要求极高的项目选择Claude 4.1 Opus,成本敏感或需要技术自主的项目选择gpt-oss-120b。通过 API易 apiyi.com 可以同时体验两个模型,进行真实场景对比测试。

✅ Claude 4.1 Opus API vs gpt-oss-120b API 最佳实践

| 实践领域 | Claude 4.1 Opus策略 | gpt-oss-120b策略 | 通用建议 |

|---|---|---|---|

| 🎯 项目规划 | 优先考虑质量关键型项目 | 适用于成本敏感和实验性项目 | 根据项目特性选择 |

| ⚡ 部署策略 | 使用API或云平台部署 | 评估自部署vs云端API | 考虑技术能力和成本 |

| 💡 开发流程 | 集成现有开发流程 | 建立本地开发环境 | 确保团队技能匹配 |

📋 技术选型决策框架

| 决策因素 | 权重 | Claude优势场景 | gpt-oss优势场景 |

|---|---|---|---|

| 预算约束 | 25% | 充足预算,质量优先 | 预算有限,成本敏感 |

| 技术要求 | 30% | 复杂推理,代码生成 | 一般应用,定制需求 |

| 数据安全 | 20% | 可接受云端处理 | 严格本地化要求 |

| 团队能力 | 15% | 专注业务开发 | 具备运维能力 |

| 扩展需求 | 10% | 标准化需求 | 需要深度定制 |

🛠️ 技术咨询建议:针对复杂的技术选型决策,API易 apiyi.com 提供了专业的技术咨询服务。我们的专家团队可以根据您的具体需求,提供定制化的模型选择和部署方案建议。

🔍 混合部署策略

# 智能模型路由系统

class HybridModelRouter:

def __init__(self):

self.claude_client = self.init_claude_client()

self.gpt_oss_local = self.init_local_gpt_oss()

self.gpt_oss_api = self.init_gpt_oss_api()

# 路由规则配置

self.routing_rules = {

"high_complexity": "claude",

"cost_sensitive": "gpt_oss_local",

"medium_quality": "gpt_oss_api",

"privacy_critical": "gpt_oss_local"

}

def classify_request(self, request: str) -> str:

"""分析请求类型"""

if self.is_coding_task(request):

return "high_complexity"

elif self.is_sensitive_data(request):

return "privacy_critical"

elif self.is_batch_processing(request):

return "cost_sensitive"

else:

return "medium_quality"

async def route_request(self, request: str):

"""智能路由请求"""

request_type = self.classify_request(request)

model_choice = self.routing_rules[request_type]

if model_choice == "claude":

return await self.call_claude(request)

elif model_choice == "gpt_oss_local":

return await self.call_local_gpt_oss(request)

else:

return await self.call_gpt_oss_api(request)

def optimize_costs(self):

"""成本优化分析"""

return {

"total_requests": self.get_request_stats(),

"cost_breakdown": self.calculate_cost_breakdown(),

"optimization_suggestions": self.generate_suggestions()

}

# 使用示例

router = HybridModelRouter()

# 自动选择最优模型

result = await router.route_request("设计一个高并发的支付系统架构")

🚨 混合策略建议:对于有复杂需求的企业,建议采用混合部署策略。高价值任务使用Claude 4.1 Opus,一般任务使用gpt-oss-120b,通过 API易 apiyi.com 的智能路由服务,可以实现自动化的模型选择和成本优化。

❓ Claude 4.1 Opus API vs gpt-oss-120b API 常见问题

Q1: 开源模型gpt-oss-120b在数据安全方面有什么优势?

开源模型在数据安全方面具有显著优势:

完全本地化部署:

- 所有数据处理都在本地进行,无需发送到外部服务器

- 消除了数据泄露和隐私侵犯的风险

- 满足严格的合规要求(如GDPR、HIPAA等)

技术透明性:

- 可以检查模型权重和架构,确保无后门

- 审计训练数据和处理逻辑

- 自主控制模型的使用和修改

定制化安全措施:

# 安全部署示例

class SecureGPTOSSDeployment:

def __init__(self):

self.model = self.load_verified_model()

self.setup_security_measures()

def setup_security_measures(self):

"""配置安全措施"""

# 网络隔离

self.enable_network_isolation()

# 数据加密

self.enable_data_encryption()

# 访问控制

self.setup_access_control()

# 审计日志

self.enable_audit_logging()

def process_sensitive_data(self, data):

"""安全处理敏感数据"""

# 数据预处理和脱敏

sanitized_data = self.sanitize_data(data)

# 本地推理

result = self.model.generate(sanitized_data)

# 结果后处理

return self.post_process_result(result)

推荐方案:对于有严格数据安全要求的组织,强烈建议使用 gpt-oss-120b 进行本地部署。API易 apiyi.com 提供了完整的安全部署指导和技术支持,确保模型部署符合各种合规标准。

Q2: 在什么情况下Claude 4.1 Opus的高成本是值得的?

Claude 4.1 Opus的高成本在以下场景中具有明确的投资回报:

高价值业务场景:

- 金融风控模型开发:错误成本极高,需要最高质量

- 医疗诊断辅助:准确性直接关系患者安全

- 法律文档分析:精确性要求严格

- 企业战略规划:决策质量影响公司发展

效率提升价值:

# ROI计算示例

class ClaudeROICalculator:

def calculate_value_proposition(self, project_type):

if project_type == "enterprise_software":

# 高级工程师时薪 $100,Claude节省50%开发时间

developer_savings = 1000 * 0.5 * 100 # $50,000

claude_cost = 5000 # 月度使用成本

roi = (developer_savings - claude_cost) / claude_cost * 100

return f"ROI: {roi}% - 投资回报率极高"

elif project_type == "financial_analysis":

# 避免一次重大决策错误的价值

risk_mitigation_value = 1_000_000

claude_cost = 10_000

return f"风险缓解价值: ${risk_mitigation_value}, 成本: ${claude_cost}"

质量关键场景:

- 代码审查:Claude的74.5% SWE-bench成绩远超其他模型

- 复杂推理:Extended Thinking提供透明的推理过程

- 大规模文档处理:200K上下文窗口无与伦比

时间敏感项目:

- 紧急项目交付:高质量输出减少返工时间

- 竞争性开发:快速获得最佳方案的优势

- 创新探索:顶级模型能力推动创新边界

决策建议:当项目的成功对业务具有重大影响,且质量要求超过成本考虑时,Claude 4.1 Opus是明智选择。建议通过 API易 apiyi.com 进行ROI评估,确定具体项目的投资价值。

Q3: 如何选择gpt-oss-120b的最优部署方式?

gpt-oss-120b的部署方式选择需要综合考虑多个因素:

部署方式对比:

| 部署方式 | 适用场景 | 优势 | 劣势 |

|---|---|---|---|

| 云端API | 测试、小规模应用 | 无需硬件、快速上手 | 持续成本、数据外流 |

| 本地GPU | 中等规模、数据敏感 | 成本可控、数据安全 | 需要技术维护 |

| 云端自建 | 大规模、弹性需求 | 可扩展、专业运维 | 复杂度高、成本较高 |

硬件需求分析:

# 硬件需求评估

class HardwareRequirements:

def __init__(self):

self.model_size = "120B parameters"

self.memory_requirements = {

"fp16": "240GB", # 16-bit精度

"int8": "120GB", # 8-bit量化

"int4": "60GB" # 4-bit量化

}

def recommend_hardware(self, budget, performance_req):

if budget > 20000 and performance_req == "high":

return {

"gpu": "8x A100 80GB",

"memory": "512GB RAM",

"storage": "4TB NVMe SSD",

"estimated_cost": "$25,000/month"

}

elif budget > 5000 and performance_req == "medium":

return {

"gpu": "2x RTX 4090",

"memory": "128GB RAM",

"storage": "1TB NVMe SSD",

"estimated_cost": "$3,000/month"

}

else:

return {

"recommendation": "使用云端API",

"reason": "硬件投入成本过高,不如直接使用API服务"

}

def deployment_decision_tree(self, monthly_tokens, data_sensitivity, tech_capability):

"""部署决策树"""

if data_sensitivity == "high":

return "本地部署"

elif monthly_tokens < 1_000_000:

return "云端API"

elif tech_capability == "strong" and monthly_tokens > 10_000_000:

return "本地部署"

else:

return "云端API"

部署最佳实践:

# 生产级部署脚本示例

#!/bin/bash

# 1. 环境准备

docker pull vllm/vllm-openai:latest

# 2. 模型下载(需要足够存储空间)

huggingface-cli download OpenAI/gpt-oss-120b

# 3. 启动服务(多GPU配置)

docker run -d \

--name gpt-oss-production \

--gpus all \

--shm-size=32g \

-p 8000:8000 \

-v /path/to/models:/models \

-e CUDA_VISIBLE_DEVICES=0,1,2,3 \

vllm/vllm-openai:latest \

--model /models/gpt-oss-120b \

--tensor-parallel-size 4 \

--max-model-len 32768

# 4. 健康检查

curl http://localhost:8000/health

# 5. 性能测试

python benchmark_deployment.py

专业建议:部署方式的选择直接影响长期成本和性能。API易 apiyi.com 提供了完整的部署咨询服务,包括硬件选型、性能优化和运维支持,帮助用户选择最适合的部署策略。

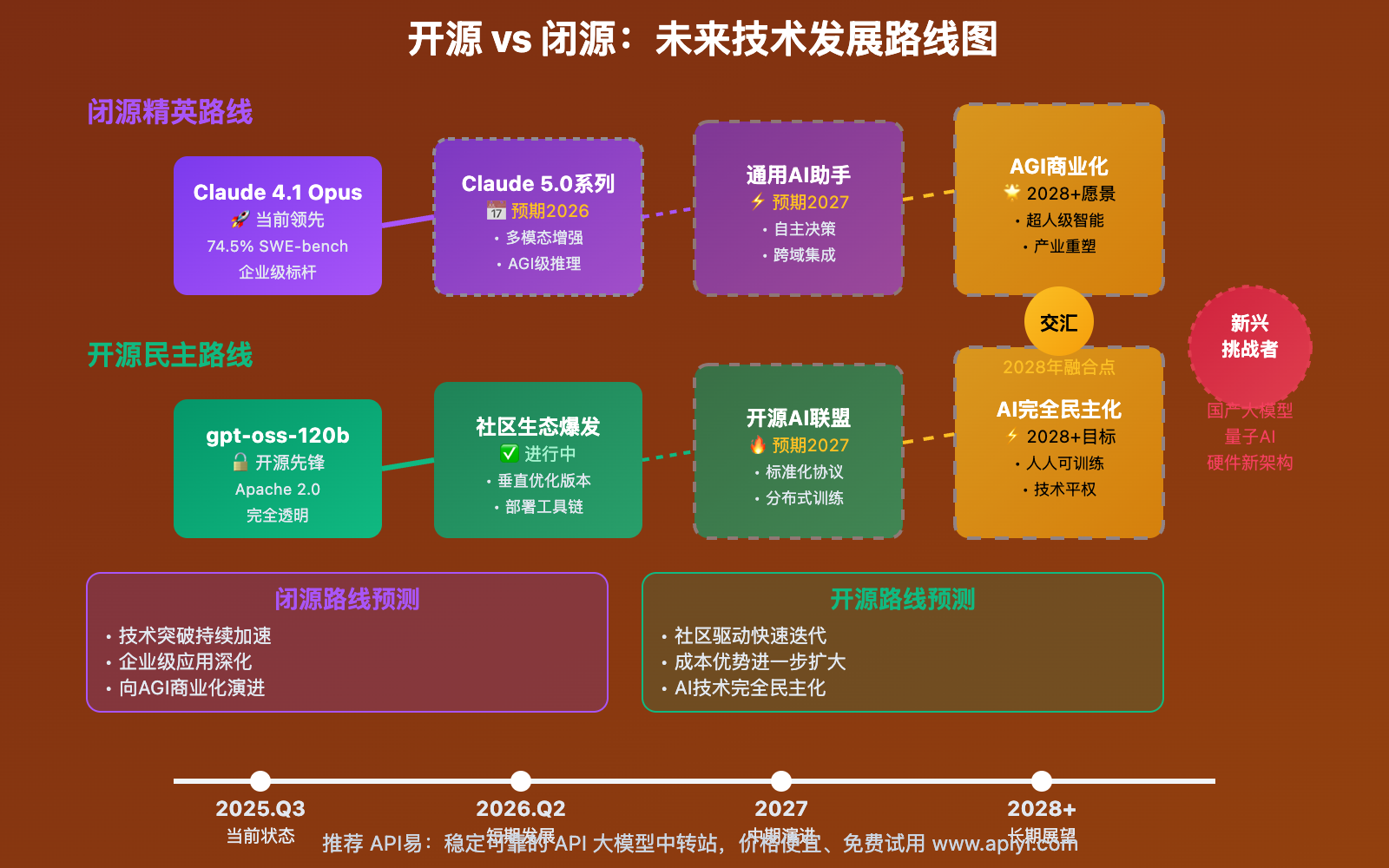

Q4: 两个模型在未来发展方向上有什么差异?

两个模型代表了AI发展的不同路径,未来走向也截然不同:

Claude 4.1 Opus发展方向:

- 技术精进:持续提升推理深度和代码能力

- 企业化:强化安全性、可靠性和企业级功能

- 专业化:针对特定行业深度优化

- 生态建设:与企业软件生态深度集成

gpt-oss-120b发展路径:

- 社区驱动:开源社区贡献和改进

- 多样化:衍生出各种专业化版本

- 民主化:降低AI技术使用门槛

- 创新加速:促进AI研究和应用创新

市场趋势分析:

# 市场发展趋势预测

class MarketTrendAnalysis:

def predict_2026_landscape(self):

return {

"闭源模型趋势": {

"claude_direction": "超大规模、超高质量、垂直专业化",

"market_share": "高端企业市场主导",

"price_trend": "维持高价,按价值计费"

},

"开源模型趋势": {

"gpt_oss_direction": "社区化改进、多元化应用、技术普及",

"market_share": "中低端市场、学术研究、创新应用",

"cost_trend": "持续降低,硬件效率提升"

},

"融合趋势": {

"hybrid_solutions": "混合部署成为主流",

"api_standardization": "API标准化程度提高",

"ecosystem_integration": "生态系统深度整合"

}

}

def recommend_long_term_strategy(self, organization_type):

if organization_type == "large_enterprise":

return {

"primary": "Claude生态深度集成",

"secondary": "gpt-oss作为辅助和实验",

"strategy": "质量优先,成本次要"

}

elif organization_type == "startup":

return {

"primary": "gpt-oss降低成本门槛",

"secondary": "关键功能使用Claude",

"strategy": "成本控制,快速迭代"

}

else: # research/academic

return {

"primary": "gpt-oss研究和改进",

"secondary": "Claude作为基准对比",

"strategy": "技术探索,开放创新"

}

投资建议:

- 企业用户:长期投资Claude生态,建立竞争优势

- 技术团队:掌握两套技术栈,灵活应对需求变化

- 研究机构:重点关注开源发展,参与技术创新

技术准备:无论选择哪条路径,都需要建立相应的技术能力。API易 apiyi.com 提供了完整的技术培训和咨询服务,帮助组织制定长期的AI技术策略和人才培养计划。

📚 延伸阅读

🛠️ 开源资源

完整的模型对比和部署资源已开源:

# 克隆对比项目

git clone https://github.com/apiyi-api/claude-vs-gpt-oss-comparison

cd claude-vs-gpt-oss-comparison

# 环境配置

export CLAUDE_API_KEY=your_claude_key

export GPT_OSS_API_KEY=your_gpt_oss_key

export API_BASE_URL=https://vip.apiyi.com/v1

# 运行性能对比

python compare_models.py --tasks coding,reasoning,analysis

python cost_analysis.py --usage-scenarios small,medium,large

python deployment_guide.py --hardware-budget 5000

开源资源包括:

- 双模型性能基准测试套件

- 成本效益分析工具

- 部署自动化脚本

- 混合部署架构模板

- 安全配置最佳实践

📖 学习建议:深入理解开源与闭源模型的差异需要实际操作。建议通过 API易 apiyi.com 获取两个模型的测试账号,进行并行对比实验,亲身体验不同模型的特点和适用场景。

🔗 相关文档

| 资源类型 | 推荐内容 | 获取方式 |

|---|---|---|

| 官方文档 | Claude 4.1 Opus技术文档 | https://docs.anthropic.com |

| 开源项目 | gpt-oss-120b模型权重 | https://huggingface.co/OpenAI/gpt-oss-120b |

| 部署指南 | API易多模型部署手册 | https://help.apiyi.com |

| 社区讨论 | 开源vs闭源模型论坛 | GitHub、Reddit、HackerNews |

持续学习建议:AI模型技术快速发展,建议定期关注 API易 help.apiyi.com 的技术动态,获取最新的模型对比分析、部署案例和行业最佳实践,保持技术决策的前瞻性。

🎯 总结

Claude 4.1 Opus API vs gpt-oss-120b API 的对比揭示了AI产业"精英化"与"民主化"两种发展模式的深层次差异。

重点回顾:Claude代表极致质量与企业级保障,gpt-oss代表技术开放与成本优化

核心选择建议:

- 追求极致质量:选择Claude 4.1 Opus,适合高价值业务和复杂工程

- 注重成本控制:选择gpt-oss-120b,适合大规模部署和成本敏感场景

- 重视技术自主:选择gpt-oss-120b,满足数据安全和定制化需求

- 混合部署策略:结合两者优势,实现效益最大化

技术发展趋势:

- 闭源模型将持续在质量和专业化方面领先

- 开源模型将在可访问性和创新速度方面占优

- 混合部署将成为企业的主流选择

- API标准化程度将不断提高

最终建议:在开源与闭源的选择中,没有绝对的对错,关键在于与业务需求的匹配度。我们强烈推荐使用 API易 apiyi.com 作为统一的AI模型管理平台,它不仅提供了Claude 4.1 Opus和gpt-oss-120b的稳定接入服务,还有完整的性能对比工具、成本分析系统和混合部署支持,帮助用户在复杂的技术选择中找到最优解。

📝 作者简介:资深AI架构师,专注开源与闭源模型的对比研究与企业级应用实践。长期跟踪AI产业发展趋势,更多技术洞察和实战案例可访问 API易 apiyi.com 技术社区。

🔔 技术交流:欢迎在评论区讨论开源与闭源模型的选择策略,持续分享AI技术发展动态和应用心得。如需专业的模型选型和部署咨询,可通过 API易 apiyi.com 联系我们的技术专家团队。