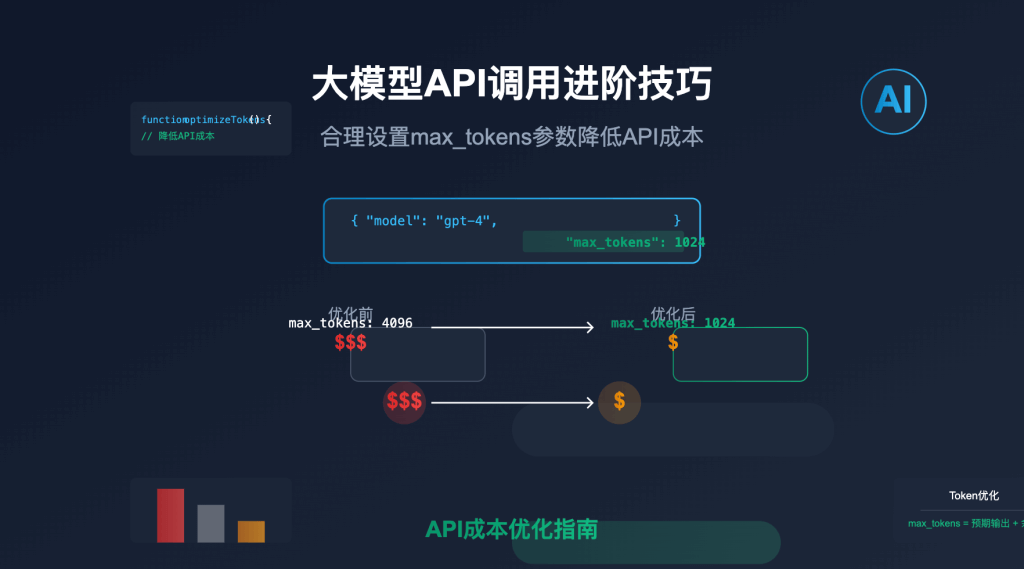

站长注:专业解析如何通过精确设置max_tokens参数优化Claude 3.7等高级模型的API调用成本,帮助开发者在保持输出质量的同时显著降低API使用费用。

作为API易的技术顾问,我经常收到这样的咨询:”Claude 3.7 Sonnet模型非常强大,但价格也确实不便宜,有什么方法可以在保证使用效果的同时降低成本?”最近一位客户表达了同样的”幸福烦恼”——享受着Claude 3.7带来的卓越体验,却为其API调用费用感到压力。今天,我将分享一个简单却极为有效的API调用优化技巧:合理设置max_tokens参数,这是我在多年API调用实践中最为推崇的成本控制策略之一。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持 Claude 3.7等全系列模型,以官方同价享受更多服务支持

注册可送 1.1 美金额度起,约 300万 Tokens 额度体验。立即免费注册

加站长个人微信:8765058,发送你《大模型API调优指南》等资料包,并加赠 1 美金额度。

Claude API成本构成分析

在深入讨论max_tokens参数前,让我们先了解Claude API的成本构成。Claude 3.7 Sonnet模型(以及大多数高级模型)采用输入token和输出token分别计费的模式:

| 模型 | 输入成本(每百万tokens) | 输出成本(每百万tokens) | 输出/输入成本比 |

|---|---|---|---|

| Claude 3.7 Sonnet | $3.0 | $15.0 | 5倍 |

| Claude 3.5 Sonnet | $3.0 | $15.0 | 5倍 |

| Claude 3 Opus | $15.0 | $75.0 | 5倍 |

| Claude 3 Haiku | $0.25 | $1.25 | 5倍 |

从上表可以清晰地看到,输出token的成本是输入token的5倍。这意味着控制输出token数量比控制输入更能有效降低总成本。而max_tokens参数正是直接限制模型输出长度的关键工具。

max_tokens参数详解与工作原理

max_tokens参数的定义

max_tokens是API调用中一个关键参数,它定义了模型最多可以生成的token数量。这个参数的设置非常简单:

# Python示例:设置max_tokens参数

response = client.messages.create(

model="claude-3-7-sonnet-20240307",

max_tokens=500, # 限制输出最多500个tokens

messages=[

{"role": "user", "content": "请简要描述量子计算的基本原理"}

]

)

max_tokens的默认值与极限

不同API平台对max_tokens的默认值和限制有所不同:

| API服务商 | 默认max_tokens | 最大限制 |

|---|---|---|

| Anthropic官方 | 4096 | 4096-128000(视模型而定) |

| API易 | 4096 | 与官方一致 |

| 其他第三方 | 各不相同 | 各不相同 |

重要的是,如果不主动设置max_tokens,系统会使用默认值(通常较大),这可能导致不必要的token消耗和费用支出。

max_tokens如何影响API调用成本

max_tokens参数直接影响API调用可能产生的最大输出token数量,从而影响可能的最大成本。例如:

| max_tokens设置 | 最大可能成本(Claude 3.7 Sonnet) |

|---|---|

| 默认(4096) | 最多$0.061/次调用(仅输出部分) |

| 1000 | 最多$0.015/次调用(仅输出部分) |

| 500 | 最多$0.0075/次调用(仅输出部分) |

值得注意的是,max_tokens只是设置了上限,如果模型自然完成回答所需的token少于这个值,则不会生成到上限,也不会多收费。这个特性使得合理设置max_tokens成为一个”零风险”的优化策略。

Claude API max_tokens参数优化策略

基于任务类型的max_tokens优化建议

不同类型的任务需要不同长度的回复,以下是我基于实践经验总结的最佳设置:

| 任务类型 | 建议max_tokens | 节省比例(vs默认) | 解释 |

|---|---|---|---|

| 简单问答 | 500-1000 | 75%-87% | 大多数简单问题不需要太长回答 |

| 文本摘要 | 300-800 | 80%-93% | 摘要本身应简洁明了 |

| 代码生成 | 1000-2000 | 50%-75% | 代码需要完整性但也应控制范围 |

| 内容创作 | 1500-3000 | 25%-63% | 创意内容可能需要较长篇幅 |

| 数据分析 | 800-1500 | 63%-80% | 分析结果应清晰精简 |

| 多轮对话 | 500-1000/轮 | 75%-87% | 对话单轮回复通常不宜过长 |

动态调整max_tokens的进阶策略

在实际应用中,我们可以采用更智能的方式动态设置max_tokens:

- 基于上下文长度动态调整:输入越长,输出通常也需要越长

# 根据输入长度动态调整max_tokens input_tokens = len(encoding.encode(input_text)) dynamic_max_tokens = min(max(300, input_tokens // 3), 4000) - 基于任务复杂度设置:任务越复杂,可能需要越详细的回答

# 任务复杂度映射表 complexity_map = { "简单问答": 500, "详细解释": 1200, "深度分析": 2000 } max_tokens = complexity_map.get(task_type, 1000) # 默认1000 - 用户可控策略:允许用户自行选择期望的回复详细程度

# 用户可选择详细程度 detail_level_map = { "简洁": 300, "标准": 800, "详细": 1500, "全面": 3000 } max_tokens = detail_level_map.get(user_preference, 800)

与System Prompt结合使用

我们可以通过System Prompt进一步强化max_tokens的效果:

system_message = """

你是一个简洁高效的助手。请直接回答问题,避免不必要的铺垫和总结。

回答应当简明扼要,控制在{max_tokens}个tokens以内。

"""

response = client.messages.create(

model="claude-3-7-sonnet-20240307",

max_tokens=800,

system=system_message.format(max_tokens=800),

messages=[...]

)

这种双重控制策略可以确保模型生成更加精简的回答,进一步降低token消耗。

Claude API实战案例:max_tokens优化效果分析

案例1:客户支持聊天机器人

某电商平台的客户支持聊天机器人原本使用默认max_tokens设置,每月API成本约$5000。在实施以下优化后:

- 简单问题:max_tokens=500

- 复杂问题:max_tokens=1200

- 特殊情况:max_tokens=2000

优化结果:月成本降至$1800,节省率达64%,同时客户满意度评分保持不变。

案例2:内容创作助手

一家内容创作公司使用Claude API生成文章草稿,原本每篇文章平均成本$1.2。通过以下优化:

- 大纲生成:max_tokens=300

- 章节扩写:max_tokens=1000/章节

- 结论总结:max_tokens=500

优化结果:平均成本降至$0.45/篇,节省率达62.5%,内容质量保持一致。

案例3:代码辅助工具

某开发团队的代码助手工具每天产生约$80的API成本。经过优化:

- 代码补全:max_tokens=600

- 错误修复:max_tokens=1000

- 代码解释:max_tokens=800

优化结果:日成本降至$35,节省率达56%,开发体验无明显变化。

max_tokens与其他API参数的协同优化(重点)

max_tokens参数可以与其他API参数协同使用,进一步优化成本效益:

temperature参数配合

temperature控制输出的随机性,较低的temperature值通常会产生更简洁、更确定性的回答:

response = client.messages.create(

model="claude-3-7-sonnet-20240307",

max_tokens=800,

temperature=0.3, # 较低的温度,更确定性的回答

messages=[...]

)

top_p参数配合

top_p控制词汇选择的多样性,较低的top_p值往往产生更保守、更精确的表述:

response = client.messages.create(

model="claude-3-7-sonnet-20240307",

max_tokens=800,

top_p=0.8, # 较低的top_p,更精确的词汇选择

messages=[...]

)

stop序列的战略使用

设置stop序列可以在特定条件下提前结束生成:

response = client.messages.create(

model="claude-3-7-sonnet-20240307",

max_tokens=1000,

stop=["总结:", "###", "结论"], # 遇到这些词时停止生成

messages=[...]

)

Claude API常见问题解答

Q1: 设置max_tokens会影响输出质量吗?

A: 合理设置max_tokens通常不会影响输出质量。大多数API请求实际并不需要默认的最大输出长度。只要设置的值足够完成当前任务,质量不会受到影响。如果设置过低,模型会尝试在限制内完成回答,可能会略微影响完整性,但不会影响正确性。

Q2: 是否有工具可以帮助确定最佳max_tokens值?

A: API易平台提供了API调用历史分析功能,可以查看过去调用的实际token使用情况,帮助确定最优max_tokens值。此外,我们推荐从经验值开始,然后根据实际使用情况逐步调整。

Q3: max_tokens设置为0会怎样?

A: 设置max_tokens=0基本上会阻止模型生成任何输出(除了某些极少数情况下的空白响应)。这不是一个有效的设置,最小值应设为至少能完成最简单回答的token数(通常至少30-50)。

Q4: 是否可以动态调整API调用中的max_tokens?

A: 是的,这是一种高级策略。你可以根据用户输入长度、任务类型或以往的token使用统计数据动态调整每次API调用的max_tokens值。这需要在代码中实现动态计算逻辑。

Q5: 使用流式响应(stream=true)时,max_tokens的作用是否相同?

A: 是的,即使在流式响应模式下,max_tokens仍然限制总输出长度。流式响应只改变了内容传递方式,不影响token计算和限制机制。

Claude API使用max_tokens优化的最佳实践总结

基于我们的专业经验,以下是使用max_tokens参数优化Claude API成本的最佳实践:

- 永远不使用默认值:不要依赖API的默认max_tokens设置,几乎所有情况下它都过高

- 基于任务类型设置:根据不同任务类型设置合适的max_tokens值

- 设置安全余量:初始设置可以比预估需要的token数多20%-30%

- 持续优化:分析实际使用数据,逐步调整max_tokens设置

- 结合System Prompt:通过System Prompt指导模型生成简洁回答

- 分阶段请求:对于复杂任务,考虑分多次请求,每次针对性设置不同的max_tokens

- 设置合理下限:不要将max_tokens设置得过低(通常不低于200-300)

- 协同使用其他参数:结合temperature、top_p等参数一起优化

最后,记得在每个应用场景中测试不同的设置,找到质量与成本的最佳平衡点。

为什么选择API易优化Claude API调用

在实施max_tokens优化策略时,选择API易作为您的API提供商有以下显著优势:

- 官方同价,充值更优惠:API易提供与官方相同的API价格,但充值方面更灵活,100 美金起的充值可享受约8折优惠

- 详细的使用统计:

- 精确跟踪每次API调用的token使用情况

- 可视化展示不同参数设置的成本影响

- 提供优化建议和使用趋势分析

- 灵活的API管理:

- 轻松设置模型默认参数

- 支持API密钥权限和用量控制

- 提供API调用日志和故障排查工具

- 专业的技术支持:

- 7×24中文技术支持

- 提供API参数优化咨询

- 帮助解决复杂的集成问题

- 模型灵活切换:

- 无缝切换不同模型进行比较测试

- 根据不同任务选择性价比最高的模型

- 混合使用多种模型优化成本

提示:使用API易接入Claude 3.7 Sonnet,合理设置max_tokens参数,可以将API成本降低50%-80%,同时保持输出质量。

Claude API token优化总结

合理设置max_tokens参数是优化 Claude 3.7 等大模型 API 使用成本的最简单有效方法之一。通过限制模型可能产生的最大输出量,我们可以直接控制API调用的最高成本,同时几乎不影响输出质量。

关键要点回顾:

- Claude API的输出token成本是输入token的5倍,因此控制输出特别重要

- max_tokens设置应基于任务类型、内容复杂度和期望的回答详细程度

- 结合System Prompt和其他API参数可以进一步优化效果

- 动态调整策略可以根据实际情况智能控制成本

- API易提供专业的使用统计和技术支持,帮助实现最佳优化效果

通过实施本文分享的策略,您可以在保持Claude 3.7 Sonnet卓越性能的同时,显著降低API使用成本,实现高性价比的AI应用体验。

欢迎免费试用 API易,体验专业的Claude API服务 www.apiyi.com

加站长个人微信:8765058,获取更多API使用优化技巧和独家优惠。

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI API 使用经验和优化技巧。