前言:这篇文章我详细分析 Deepseek Reasoner (R1) 模型响应慢的原因,并提供实用的性能优化方案。

欢迎免费试用 API易,3 分钟跑通 Deepseek API 调用 www.apiyi.com

支持 Deepseek R1 等全系列模型,让你的 AI 应用更智能注册即送 1.1 美金额度起,约 300万 Tokens的 deepseek-chat 额度体验。立即免费注册>

问题分析

最近有用户反馈 Deepseek Reasoner (R1) 模型偶尔会出现响应较慢的情况。这个问题需要从多个角度来分析:

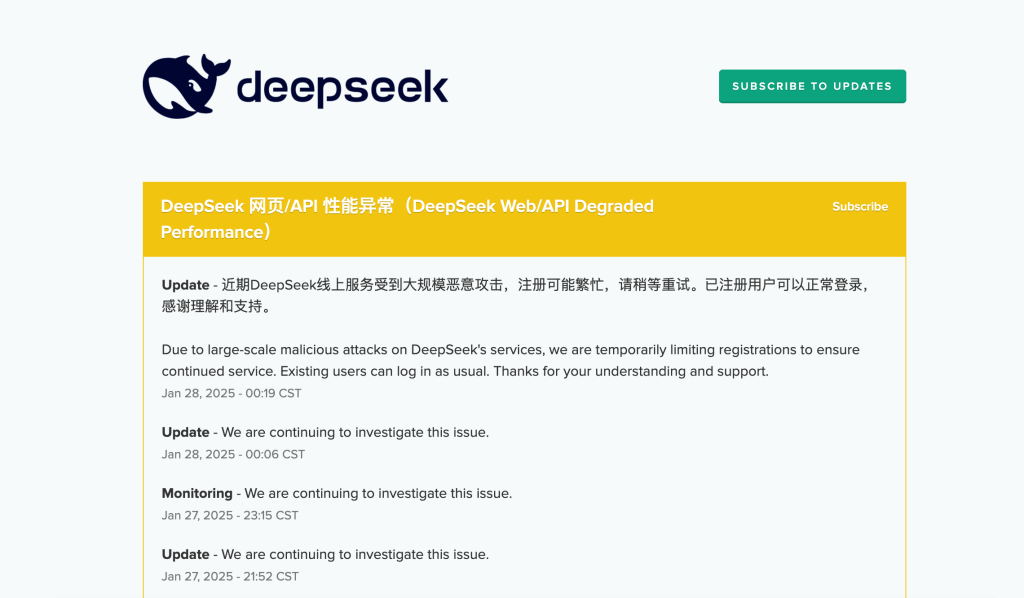

0. 核心原因是当前服务负荷重

最近太火了,先排除是否是官方问题,请看 Deepseek 的监控页面↓

1. 模型特性导致

Deepseek R1 是一个专注于推理能力的模型,其特点是:

- 内置思维链(Chain of Thought)

- 强化了逻辑推理能力

- 性能对标 OpenAI o1 正式版

正是因为模型会进行深度的逻辑推理,所以响应时间会比普通对话模型更长。这不是 bug,而是特性。

2. 影响响应速度的因素

响应时间主要受以下因素影响:

- 问题的复杂度(不是文本长度)

- 需要的推理步骤数量

- 当前服务负载情况

- 网络连接质量

性能优化建议

1. 代码层面优化

实现超时重试机制

import openai

from tenacity import retry, stop_after_attempt, wait_exponential

@retry(

stop=stop_after_attempt(3), # 最多重试 3 次

wait=wait_exponential(multiplier=1, min=4, max=10) # 指数退避

)

def call_deepseek_api(prompt):

try:

response = openai.chat.completions.create(

model="deepseek-reasoner",

messages=[{"role": "user", "content": prompt}],

timeout=60 # 设置 60 秒超时

)

return response

except openai.APITimeoutError:

print("请求超时,将自动重试")

raise # 触发重试机制

except Exception as e:

print(f"发生错误: {str(e)}")

raise

使用异步调用

import asyncio

import openai

async def async_call_deepseek(prompt):

try:

response = await openai.chat.completions.create(

model="deepseek-reasoner",

messages=[{"role": "user", "content": prompt}]

)

return response

except Exception as e:

print(f"异步调用出错: {str(e)}")

return None

# 使用示例

async def main():

prompts = ["问题1", "问题2", "问题3"]

tasks = [async_call_deepseek(p) for p in prompts]

results = await asyncio.gather(*tasks)

return results

2. 提示词优化

有效的提示词结构

prompt = """

请按以下步骤解决问题:

1. 首先,...

2. 然后,...

3. 最后,...

问题:{your_question}

"""

避免冗余信息

- 删除无关上下文

- 明确指定需要的输出格式

- 避免重复的指令

3. 网络优化

- 检查网络稳定性

import requests import time def check_network(): start_time = time.time() try: response = requests.get("https://vip.apiyi.com/v1/health") latency = time.time() - start_time print(f"网络延迟: {latency:.2f}秒") return response.status_code == 200 except: print("网络连接异常") return False - 使用更稳定的网络环境

- 考虑使用云服务器

- 确保网络带宽充足

- 避免使用不稳定的网络

性能监控方案

1. 响应时间监控

import time

from datetime import datetime

def monitor_api_call(func):

def wrapper(*args, **kwargs):

start_time = time.time()

result = func(*args, **kwargs)

duration = time.time() - start_time

# 记录调用信息

log_entry = {

'timestamp': datetime.now().isoformat(),

'duration': duration,

'success': result is not None

}

# 可以将 log_entry 保存到文件或数据库

print(f"API 调用耗时: {duration:.2f}秒")

return result

return wrapper

@monitor_api_call

def call_api(prompt):

# 你的 API 调用代码

pass

2. 错误追踪

class APICallTracker:

def __init__(self):

self.error_counts = {}

self.total_calls = 0

def track_error(self, error_type):

if error_type not in self.error_counts:

self.error_counts[error_type] = 0

self.error_counts[error_type] += 1

def get_error_rate(self, error_type):

return self.error_counts.get(error_type, 0) / self.total_calls if self.total_calls > 0 else 0

tracker = APICallTracker()

常见问题解答

1. 为什么推理模型会比较慢?

推理模型需要进行复杂的逻辑分析和推理,这个过程类似于人类的思考过程。模型会:

- 分解问题为多个步骤

- 进行逻辑推理

- 验证中间结果

- 生成最终答案

2. 如何判断是否是性能问题?

观察以下指标:

- 响应时间是否超过 30 秒

- 是否出现频繁超时

- 错误率是否异常

- 网络延迟是否正常

3. 如何优化推理任务?

- 将复杂问题拆分为多个小问题

- 使用结构化的提示词

- 实现合理的重试机制

- 优化网络环境

总结

Deepseek R1 模型的响应时间受多个因素影响,通过合理的代码优化、提示词优化和网络优化,可以显著提升使用体验。记住,推理模型的响应时间会比普通对话模型长,这是由其深度思考和推理特性决定的。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持 Deepseek 全系列模型,专业的技术支持助你解决各类问题

本文作者:API易团队

最后更新:2025-01-20

欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。