站长注:详细解读 API易 提供的不同来源 Deepseek 模型的特点、差异和调用注意事项,帮助开发者避免常见问题。

API易 目前提供了来自两个不同渠道的 Deepseek 模型,包括 Deepseek 官方的 deepseek-chat 和 deepseek-reasoner,以及国内领先云平台的 deepseek-v3 和 deepseek-r1。模型均是满血版!!放心使用!本文将详细解读这些模型的区别和使用注意事项。推荐给每个客户们。

一句话总结的是,在当下Deepseek 官网不稳定的情况下,使用云平台的模型 deepseek-v3 和 deepseek-r1 要比 deepseek-chat 和 deepseek-reasoner 要更稳定,出错概率低且速度更快。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持 Deepseek 全系列模型,让开发更简单

注册即送 1.1 美金额度起。立即免费注册 www.apiyi.com

模型对比

1. 模型基本信息对比

附图价格部分是API易 的价格(充值角度是官网的八折),关于倍率是模型本身的基准倍率,不是说价格等于官方的多少倍。

| 特性 | deepseek-chat | deepseek-reasoner | deepseek-v3 | deepseek-r1 |

|---|---|---|---|---|

| 来源 | Deepseek 官方 | Deepseek 官方 | 云平台 | 云平台 |

| 提示词价格 | $0.3/1M tokens | $0.6/1M tokens | $0.3/1M tokens | $0.6/1M tokens |

| 补全词价格 | $1.2/1M tokens | $2.4/1M tokens | $1.2/1M tokens | $2.4/1M tokens |

| 提示倍率 | 0.15 | 0.3 | 0.15 | 0.3 |

| 补全倍率 | 4.0 | 4.0 | 4.0 | 4.0 |

2. 功能特点对比

| 模型 | 核心优势 | 主要特点 | 适用场景 |

|---|---|---|---|

| deepseek-chat | 官方原生体验 | • 对话风格自然 • 支持中英双语 • 最新版本迭代 |

• 日常对话 • 内容创作 • 知识问答 |

| deepseek-reasoner | 强大推理能力 | • 思维链输出 • 复杂推理支持 • 专业问题解决 |

• 数学推理 • 逻辑分析 • 代码生成 |

| deepseek-v3 | 稳定性优化 | • 云服务优化 • 响应速度快 • 高并发支持 |

• 企业服务 • 高并发场景 • 稳定性要求高 |

| deepseek-r1 | 企业级推理 | • 性能优化 • 并发支持好 • 容错能力强 |

• 企业推理任务 • 大规模部署 • 高可用场景 |

3. 稳定性对比

| 指标 | 官方版本 | 云平台版本 |

|---|---|---|

| 响应速度 | 不稳定 | 快速稳定 |

| 错误率 | 较高 | 较低 |

| 并发支持 | 一般 | 优秀 |

| 服务可用性 | 有告警 | 稳定 |

| 部署方式 | 官方集中 | 私有化分布式 |

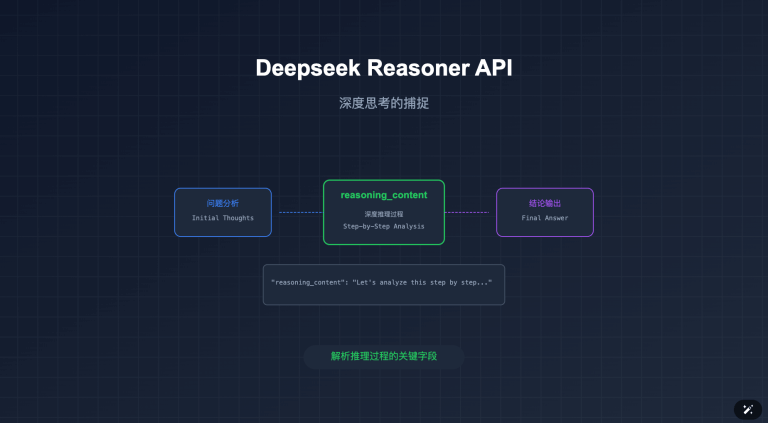

4. 推理输出格式对比

| 特性 | 官方 API | 云平台版本 |

|---|---|---|

| 推理字段 | reasoning_content | <think>标签 |

| 位置 | 独立字段 | content 内 |

| token 计数 | 单独计算 | 包含在 content 中 |

| 格式示例 | “reasoning_content”: “推理过程” | “content”: “回答<think>推理过程</think>” |

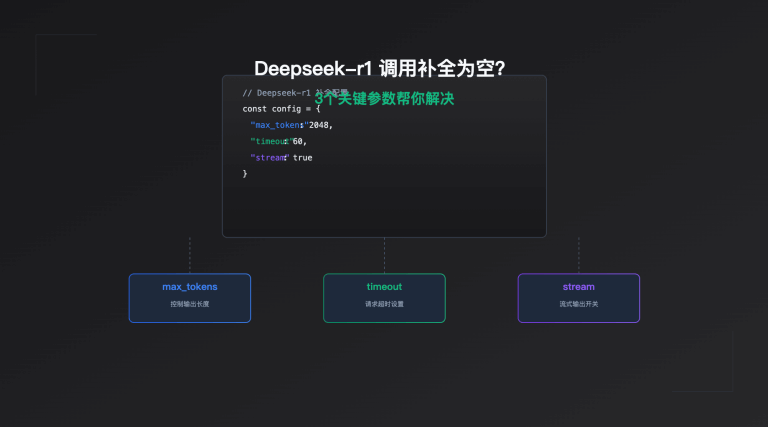

性能参数建议

| 参数 | 官方版本 | 云平台版本 | 说明 |

|---|---|---|---|

| 超时时间 | 15秒+ | 10秒内 | 根据实际情况调整 |

| 重试次数 | 2-3次 | 1-2次 | 建议使用指数退避 |

| 并发限制 | 较低 | 较高 | 根据套餐调整 |

| 错误处理 | 必需 | 建议 | 详见代码示例 |

调用差异与兼容性

1. 输出格式差异

标准对话输出(deepseek-chat / deepseek-v3)

{

"id": "chatcmpl-xxx",

"object": "chat.completion",

"created": 1677649420,

"model": "deepseek-chat",

"usage": {

"prompt_tokens": 56,

"completion_tokens": 31,

"total_tokens": 87

},

"choices": [

{

"message": {

"role": "assistant",

"content": "这是回复内容"

},

"finish_reason": "stop",

"index": 0

}

]

}

推理模型输出(deepseek-reasoner)

{

"id": "chatcmpl-xxx",

"object": "chat.completion",

"created": 1677649420,

"model": "deepseek-reasoner",

"usage": {

"prompt_tokens": 56,

"completion_tokens": 31,

"total_tokens": 87

},

"choices": [

{

"message": {

"role": "assistant",

"content": "这是回复内容",

"reasoning_content": "思维推理过程...",

"reasoning_tokens": 15

},

"finish_reason": "stop",

"index": 0

}

]

}

2. 推理输出格式说明

不同来源的推理格式

- 官方 API 格式(deepseek-reasoner)

- 使用

reasoning_content字段 - 直接展示推理内容

- 包含

reasoning_tokens计数

- 使用

- 云平台格式(deepseek-r1)

- 使用

<think>推理内容</think>标签 - 基于 DeepSeek 开源版本

- 推理过程包含在 content 中

- 使用

为什么会看到不同格式?

- API 负载均衡机制:

- API易 采用多源部署策略

- 当某个来源并发不足时,会自动切换到备用源

- 这可能导致同一个模型返回不同格式的推理内容

3. 兼容性处理建议

def extract_reasoning(response, model_name):

"""统一处理不同格式的推理内容"""

message = response.choices.message

content = message.content

reasoning = ""

# 处理官方 API 格式

if hasattr(message, 'reasoning_content'):

reasoning = message.reasoning_content

# 处理云平台格式

elif '<think>' in content:

import re

think_pattern = r'<think>(.*?)</think>'

think_matches = re.findall(think_pattern, content, re.DOTALL)

if think_matches:

reasoning = think_matches

# 从 content 中移除 think 标签

content = re.sub(think_pattern, '', content).strip()

return {

'content': content,

'reasoning': reasoning

}

def handle_model_response(response, model_name):

try:

result = extract_reasoning(response, model_name)

if result['reasoning']:

print("推理过程:", result['reasoning'])

print("回复内容:", result['content'])

except Exception as e:

print(f"处理响应时出错:{str(e)}")

# 降级处理:直接输出原始内容

print(response.choices.message.content)

4. 开发建议

- 统一处理两种格式

- 同时兼容

reasoning_content和<think>标签 - 实现格式自动识别和转换

- 为用户提供一致的输出体验

- 同时兼容

- 错误处理

- 添加格式检测逻辑

- 实现优雅的降级处理

- 记录异常情况以便追踪

- 监控建议

- 记录不同格式的出现频率

- 监控推理内容的完整性

- 跟踪异常情况的发生

模型稳定性与最佳实践

1. 稳定性对比

官方 API(deepseek-chat / deepseek-reasoner)

- 当前状态:

- 官方平台存在不稳定情况

- status.deepseek.com 显示频繁告警

- 响应时间不稳定

- 常见问题:

- 连接失败

- 响应超时

- 返回数据为空

- Cannot read properties of undefined (reading ‘0’) 等错误

云平台版本(deepseek-v3 / deepseek-r1)

- 优势:

- 响应更稳定

- 速度更快

- 错误率更低

- 支持更高并发

- 特点:

- 基于私有化部署

- 经过性能优化

- 更好的容错机制

2. 推荐使用策略

主要建议

- 优先使用云平台版本

- 首选

deepseek-v3(对话场景) - 首选

deepseek-r1(推理场景) - 更稳定的响应保证

- 更快的响应速度

- 首选

- 备用方案

- 将官方 API 作为备用

- 在云平台版本负载高时切换

- 特殊场景需求时使用

错误处理建议

def safe_model_call(primary_model, backup_model, messages):

try:

# 首先尝试云平台版本

response = client.chat.completions.create(

model=primary_model, # deepseek-v3 或 deepseek-r1

messages=messages,

timeout=10 # 设置合理的超时时间

)

return response

except Exception as e:

print(f"主模型调用失败:{str(e)}")

try:

# 失败时尝试官方 API

response = client.chat.completions.create(

model=backup_model, # deepseek-chat 或 deepseek-reasoner

messages=messages,

timeout=15 # 官方 API 可能需要更长的超时时间

)

return response

except Exception as e:

print(f"备用模型也失败了:{str(e)}")

raise

def handle_empty_response(response):

"""处理空响应的情况"""

if not response or not response.choices:

raise ValueError("收到空响应")

message = response.choices.message

if not message or not message.content.strip():

raise ValueError("响应内容为空")

return message

# 使用示例

try:

response = safe_model_call('deepseek-v3', 'deepseek-chat', messages)

message = handle_empty_response(response)

result = extract_reasoning(response, model_name)

# 处理正常响应...

except Exception as e:

# 实现适当的错误处理...

print(f"处理失败:{str(e)}")

3. 性能优化建议

- 超时设置

- 官方 API:建议 15 秒以上

- 云平台版本:建议 10 秒以内

- 根据实际情况调整

- 重试策略

- 实现指数退避重试

- 设置最大重试次数

- 在重试前切换模型

- 监控措施

- 记录响应时间

- 追踪错误率

- 监控空响应情况

常见问题解答

问题快速索引

| 问题类型 | 现象 | 解决方案 | 建议 |

|---|---|---|---|

| 稳定性问题 | 连接失败、超时 | 切换到云平台版本 | 优先使用 deepseek-v3/deepseek-r1 |

| 空响应 | undefined 错误 | 完整性检查 | 使用 handle_empty_response |

| 推理格式 | 格式不一致 | 统一处理逻辑 | 使用 extract_reasoning |

| 性能问题 | 响应慢 | 优化配置 | 参考性能参数建议 |

详细解答

1. 模型选择问题

Q:如何选择合适的模型版本?

A:根据具体需求:

- 需要自然对话:deepseek-chat/deepseek-v3

- 需要推理能力:deepseek-reasoner/deepseek-r1

- 需要稳定性:优先云平台版本

- 注重成本:选择标准对话模型

2. 计费问题

Q:推理模型的计费是否有特殊规则?

A:是的,推理模型会额外计算推理过程的 tokens,建议在开发时注意监控 reasoning_tokens 的使用量。

3. 兼容性问题

Q:如何处理不同模型的输出差异?

A:建议:

- 始终检查响应字段的存在性

- 实现通用的响应处理逻辑

- 对特殊字段做好兼容处理

4. 推理格式问题

Q:为什么同样调用 deepseek-reasoner 会看到不同的推理输出格式?

A:这是由于 API易 的负载均衡机制导致的:

- API易 同时对接了官方 API 和云平台版本

- 当某个来源的并发达到限制时,会自动切换到其他来源

- 不同来源的推理输出格式略有差异

- 建议使用统一的解析逻辑,同时兼容两种格式

5. 稳定性问题

Q:如何处理 Deepseek 官方 API 的不稳定问题?

A:建议采取以下措施:

- 优先使用云平台版本(deepseek-v3/deepseek-r1)

- 实现完善的错误处理机制

- 设置合理的超时时间

- 准备备用模型方案

6. 空响应处理

Q:如何避免 “Cannot read properties of undefined (reading ‘0’)” 等错误?

A:建议:

- 使用更稳定的云平台版本

- 实现响应数据的完整性检查

- 添加空值处理逻辑

- 做好错误捕获和处理

为什么选择 API易

- 多版本支持

- 同时支持官方和云平台版本

- 可以根据需求灵活切换

- 提供统一的接口规范

- 稳定可靠

- 多节点部署

- 智能负载均衡

- 高可用性保障

- 技术支持

- 专业的技术团队

- 7×24 小时支持

- 详细的接入文档

- 成本优势

- 官方一致的定价

- 透明的计费规则

- 更灵活的付费方式

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持 Deepseek 全系列模型,让开发更简单

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。